SGLang AI 金融 π 对(杭州站)火热来袭!

本次 SGLang Meetup 聚焦于提升大模型推理效率的核心工程挑战。活动将介绍 SGLang 创新的缓存系统,通过分层与混合架构管理来优化内存使用;分享能实现模型权重秒级更新与快速加载的中间件,以加速强化学习等场景的迭代。同时,社区也展示了在支持 GLM、Mamba 等多样化模型,以及SGLang在昇腾的大模型推理优秀实践。 SGLang 社区致力于通过开源协作,为复杂 AI 模型构建高效灵活推理引擎,欢迎广大开发者线下参会。

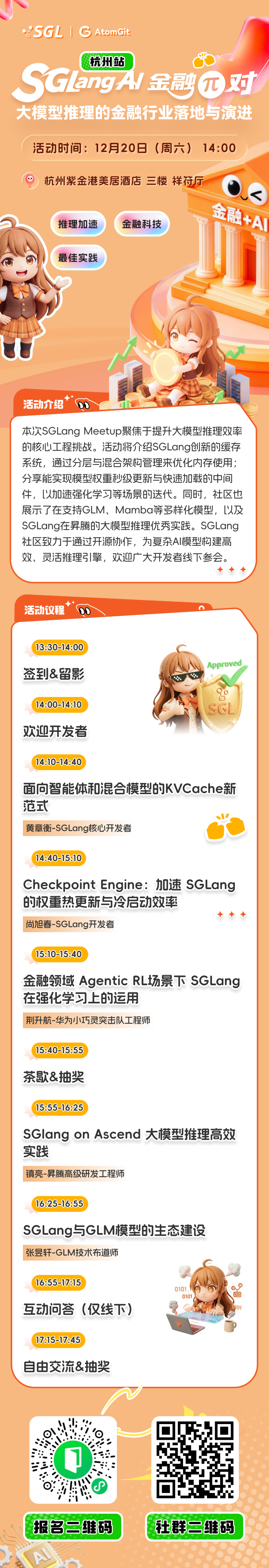

🕑 时间:12月20日(周六)14:00

📌 地点:杭州紫金港美居酒店 三楼 祥符厅

为什么一定要来?

这不是一场泛泛而谈的行业聚会,而是一场围绕 Agent、强化学习(RL)与推理系统工程的深度技术探索。

▶ 下一代推理系统的“重构现场”

面对 DeepSeek-V3 等新一代模型,传统的内存管理已捉襟见肘。本次将首度揭秘 SGLang 两大创新:HiCache 与 Hybrid Cache。从硬件到分布式存储的三级缓存体系,到支持 SparseAttention 的分层内存管理,带你从底层看透性能上限是如何被突破的。

▶ 直击 RL 训练中的“工程命门”

在强化学习与大规模推理中,权重的频繁更新是效率杀手。我们将深入探讨 Checkpoint Engine —— 专为 LLM 设计的轻量级权重更新中间件。秒级“原地”更新、Zero-Copy 技术、P2P 传输模式,这些来自一线实战的工程细节,将直接解答如何大幅缩短 RL 训练中的推理等待时间。

▶ 完整的“软硬协同+垂直落地”生态

-

看落地:华为工程师现身说法,拆解金融领域 Agentic RL 的确定性计算与多轮对轮优化;

-

看适配:SGLang 在昇腾异构环境下的真实优化路径,及对 Qwen/DeepSeek 的深度支持;

▶ SGLang与GLM模型的生态建设

随着模型尺寸的增加和MoE的模型,模型推理的重要性日益显现,GLM布道师将介绍 SGLang 与 GLM 模型的生态建设,重点介绍在 SGLang 上高效部署 GLM,包括基础的部署,PD分离,以及讲解在GLM模型适配中的一些合作历程,包括SGLang框架的适配 以及 联合研发的 Slime开源框架。

社区周边 × 限量好礼 × 抽奖福利

-

定制款周边伴手礼

-

现场抽奖:罗技 G316 X / 电竞版 8K 机械键盘、程序员定制礼盒、超级解压捏捏乐

-

参与小红书互动即可拿限定礼品

议程一览

AtomGit 是由开放原子开源基金会联合 CSDN 等生态伙伴共同推出的新一代开源与人工智能协作平台。平台坚持“开放、中立、公益”的理念,把代码托管、模型共享、数据集托管、智能体开发体验和算力服务整合在一起,为开发者提供从开发、训练到部署的一站式体验。

更多推荐

已为社区贡献213条内容

已为社区贡献213条内容

所有评论(0)