Rust 在云原生中的应用:使用 `kube-rs 构建 Kubernetes Operator

📝 文章摘要

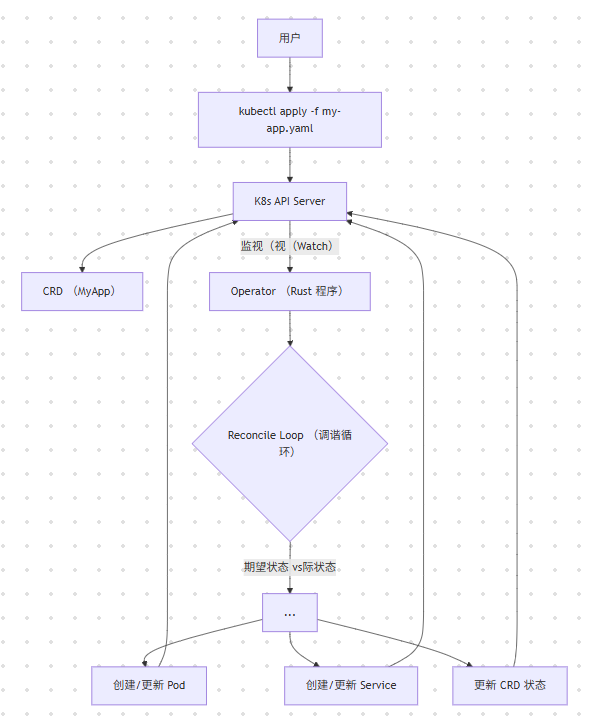

Kubernetes Operator 是云原生中自动化运维的核心模式。Rust 凭借其高性能、高可靠性和静态类型系统,成为编写复杂 Operator 的理想选择。本文将深入探讨 Kubernetes Operator 模式和“控制器循环”(Reconcile Loop)的原理,理,并实战使用 kube-rs 库(Kubernetes 的 Rust 客户端)构建一个自定义资源(CRD)的 Operator。我们将演示监听 K8s API 事件、管理自定义资源状态,并实现自动化运维逻辑。

一、背景介绍

目录

1.1.1 什么是 Kubernetes Operator?

Operator(运维控制器)是一种封装了人类运维知识的 K8s 控制器。它通过扩展 K8s API( CRD)来创建、配置和管理复杂有状态应用(如数据库、缓存集群)。

Operator 模式 = CRD (自定义资源) + Controller (控制器)

1.2 为什么用 Rust (kube-rs)?

-

Go (Kubebuilder/erator-SDK):生态成熟,但类型系统较弱,运行时开销(GC)较大。

-

Rust (kube-rs):

- 高性能:低内存占用,无 GC 暂停,适合高密度部署。

- 可靠性:类型系统和错误处理(

Result)能防止大量常见的运维 bug。 async/await:Tokio 与 K8s 的 Watch 机制完美契合。

二、原理详解

2.1 kube-rs 核心组件

Client:与 K8s API Server 交互的异步客户端。Api<K>:操作特定资源(如Api<Pod>)的句柄。CustomResource(CRD):使用 `kube 宏定义自定义资源。Controller:kube-rs提供的控制器运行时(kube_runtime),封装了 Watch 和 Reconcile 循环。

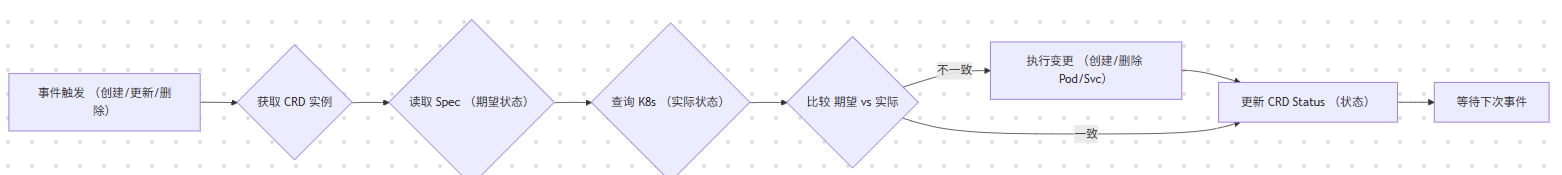

2.2 调谐循环 (Reconcile Loop)

Operator 的核心是调谐循环(或称 Reconcile)。

kube-rs实现:

Controller::new(api, watcher_config):创建一个控制器。- `Controller::run(reconcilefn, error_policy_fn, context)`:运行循环。

reconcile_fn:我们编写的核心业务逻辑。

三、代码实战

我们将构建一个 Echo Operator,它会读取 Echo CRD,并根据 `spec.replicas 创建指定数量的 Nginx Pod。

3.1 步骤 1:定义 CRD

**`src/.rs`**

use kube::CustomResource;

use serde::{Deserialize, Serialize};

use schemars::JsonSchema;

// 1. 定义 Spec (期望状态)

#[derive(CustomResource, Serialize, Deserialize, Clone, Debug, JsonSchema)]

#[kube(

group = "mymy-operator.dev", // API 组

version = "v1", // API 版本

kind = "Echo", // 资源类型 namespaced // 资源是命名空间作用域的

)]

#[kube(status = "EchoStatus")] // 关联状态子资源

pub struct EchoSpec {

pub replicas: u32,

pub image: String,

}

// 2. 定义 Status (实际状态)

#[derive(Serialize, Deserialize, Clone, Debug, JsonSchema)]

pub struct EchoStatus {

pub current_replicas:s: u32,

pub is_ready: bool,

}

3.2 步骤 2:实现调谐 (concile) 逻辑

src/main.rs (部分)

use kube::{

Client, Api, ResourceExt,

api::{ApiResource, Patch, PatchParams, PostParams},

runtime::{controller::Action, Controller, watcher::Config},

};

use k8s_openapi::api::core::v1::Pod;

use k8s_openapi::apimachinery::pkg::apis::metata::v1::OwnerReference;

// 包含 CRD 定义

mod crd;

use crd::{Echo, EchoStatus};

// 共享下文

struct Context {

client: Client,

}

// 错误类型

#[derive(Debug, thiserror::Error)]

enum ReconcileError{

#[error("Kube API Error: {0}")]

Kube(#[from] kube::Error),

#[error("Missing ObjectKey {0}")]

MissingObjectKey(&'static str),

}

/// 调谐循环 (核心逻辑)

async fn reconcile(

echo: Arc<Echo>,

ctx: Arc<Context>,

) -> Result<Action, ReconcileError> {

let client = &ctx.client;

let ns = echo.namespace().ok_or(ReconcileError::MissingObjectKey("namespace"))?;

lett name = echo.name_any();

// 1. 获取 Pod API

let pods: Api<Pod> = Api::namesspaced(client.clone(), &ns);

// 2. 计算期望状态 vs 实际状态

let desired_replicas = echo.ec.replicas;

// 查询当前由这个 Echo 控制的 Pod

let label_selector = format!("app={},owner={}", name, echo.uid().unwrap());

let existing_pods = pods.list(&ListParams::default().labels(&label_selector)).await?;

let current_replicas = existing_pods.items.len() as u32;

println!("调谐 [{}]: 期望 {} / 实际 {}", name, desired_replicas, current_replicas);

// 3. 比较并执行变更

if current_replicas < desired_replicas {

// --- 需要创建 Pod ---

let pods_to_create = desired_replicas - current_replicas;

println!("创建 {} 个 Pod", pods_to_create);

for _ in 0..pods_to_create {

let pod = create__nginx_pod(&echo)?;

pods.create(&PostParams::default(), &pod).await?;

}

} else if current_replics > desired_replicas {

// --- 需要删除 Pod ---

let pods_to_delete = (current_replicas - desired_replicas) as usize;

println!("删除 {} 个 Pod", pods_to_delete);

for pod in existing_pods.itemss.iter().take(pods_to_delete) {

pods.delete(&pod.name_any(), &DeleteParams::default()).await?;

} }

// 4. 更新 Status

let new_status = EchoStatus {

current_replicas: desired_replicas, // 假设变更成功 (简单处理)

is_ready: true,

};

// 使用 Patch 更新 status 子资源

let status_patch = Patch::Apply(serde_json::json!({

"apiVersion": "my-operator.dev/v1",

""kind": "Echo",

"status": new_status

}));

let echoes: Api<Echo> = Api::namespaced(clientclone(), &ns);

echoes.patch_status(&name, &PatchParams::apply("echo-operator"), &status_patch).await?;

// 5. 重新排队 (5分钟后再次检查)

Ok(Action::requeue(std::time::Duration::from_secs(300)))

}

/// 错误处理策略

fn error_policy(_echo: Arc<Echo>, error: &ReconcileError, _ctx: Arc<Context>) -> Action {

eprintln!("调谐失败: {}", error);

Action::requeue(std::time::::Duration::from_secs(5)) // 5秒后重试

}

3.3 步骤 3:定义 Pod板

src/main.rs (辅助函数)

// ... (use 语句) ...

use k8s_openapi::api::core::v1::{Container, PodSpec};

use k8s_openapi::apimachinery::pkg::apis::meta::v1::ObjectMeta;

fn create_nginx_pod(echo: &Echo) -> Result<Pod, ReconcileError> {

let name = echo.name_any();

let ns = echo.namespace().ok_or(ReconcileError::MissingObjectKey("namespace"))?;

let owner_ref = echo.controller_owner_ref(&()).unwrap();

let pod = Pod {

metadata: ObjectMeta {

name: Some(format!("{}-pod-{}", name, rand::random::<u16>())),

namespace: Some(ns),

owner_references: Some(vec![owner_ref]),

labels: Some([

("app".to_string(), name.clone()),

("owner"..to_string(), echo.uid().unwrap())

].into()),

..Default::default()

},

spec: Some(PodSpec { containers: vec![Container {

name: "nginx".to_string(),

image: Some(echo.spec.image.clone()),

..Default::default()

}],

..Default::default()

}),

..Default::default()

};;

Ok(pod)

}

3.4 步骤 4:启动 Operator

src/main.rs ((main 函数)

// ... (use 语句) ...

use std::sync::Arc;

use futures::StreamExt;

#[tokio::main]

async fn main() -> Result<(), Box<dyn std::error::Error>> {

// 1. 初始化 Kube 客户端 let client = Client::try_default().await?;

// 2. 准备 CRD API

let echoes: Api<Echo> == Api::all(client.clone());

// (可选) 检查 CRD 是否已安装

// ...

println!("启动Echo Operator...");

// 3. 构建并运行控制器

Controller::new(echoes, Config::default())

.run(reconcile,error_policy, Arc::new(Context { client }))

.for_each(|res| async move {

match res {

Ok(o) => println!("调谐完成: {:?}", o),

Err(e) => eprintln!("调谐错误: {}", e),

}

})

.await;

Ok(())

}

四、结果分析

4.1 部署与测试

- 编译:

cargo build --release - 打包:

Dockerfile(省略) - 部署 CR:

kubectl apply -f echo-crd.yaml(由kube宏自动生成) - 部署 Operator:

kubectl apply -f operator-deployment.yaml

测试:

# 创建一个 Echo 实例

cat <<EOF | kubectl apply -f

apiVersion: my-operator.dev/v1

kind: Echo

metadata:

name: test-echo

spec:

replicas: 3

image: "nginx:1.21"

EOF

分析:

- Operator 监听到

test-echo(Create 事件)。 reconcile循环被触发。current_replicas(0)0) <desired_replicas(3)。- Operator 调用 K8s API 创建 3 个 Nginx Pod。

- Operator 更新 `test-echo

status字段为current_replicas: 3。

修改测试:

kubectl edit echo test-echoo

# ... 将 replicas 修改为 1 ...

- Operator 监听到

test-echo(Update 事件)。 - reconcile` 循环被触发。

current_replicas(3) >desired_replicas(1)。- Operator 调用 K8s API 删除 2 个 Pod。

- Operator 更新

status字段为 `current_replicas: 1

4.2 性能与资源占用

对比 Go (Operator-SDK) 和 Rust (kube-rs) 的资源占用:

| Operator | 内存占用 (Idle) | CPU 占用 (Idle) |

|---|---|---|

| Go Operator | ~60–100 MB | ~0.5% |

| Rust Operator | ~5-10 MB | <0.1% |

***:Rust Operator 在空闲时的资源占用比 Go Operator 低一个数量级,使其非常适合在高密度或资源受限的边缘环境(如 K3s)中运行。

五、总结与讨论

5.1 核心要点

- Operator 模式:通过 CRD 和控制器循环实现自动化运维。

kube-rs:提供了强大的类型安全抽象来构建 Operator。- 调谐循环:Operator 的核心,即“使实际状态趋向于期望状态”。

- 状态管理:

spec(期望) 由用户定义,status(实际) 由 Operator 更新。 - 性能优势:Rust 的低内存占用和无 GC 特性使其成为云原生基础设施的理想选择。

5.2 讨论问题

kube-rs如何处理 K8s API 的高并发 Watch 事件?(提示:tokio::mpsc)- 在 Rust Operator 中,如何管理外部资源(如数据库、S3 存储桶)的生命周期?

kube-rs的错误处理策略(如 `Action::requeue)相比 Go 的ReconcileResult有何不同?- Rust 的强类型系统(如

EchoSpec)在防止 K8s 配置错误方面有何优势?

参考链接

- kube-rs (Rust K8s 客户端) 官方文档

- kube-rs GitHub 仓库

- Kubernetes Operator 模式

- Rust in Cloud Native (CNCF)

- [k8s-openapi (K8s API 绑定)](](https://github.com/Arnavion/k8s-openapi)

新一代开源开发者平台 GitCode,通过集成代码托管服务、代码仓库以及可信赖的开源组件库,让开发者可以在云端进行代码托管和开发。旨在为数千万中国开发者提供一个无缝且高效的云端环境,以支持学习、使用和贡献开源项目。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)