面壁智能入驻 GitCode:端侧 AI 开发获全新生产力引擎

随着移动端、边缘计算设备的普及,端侧 AI 应用正迎来爆发式增长。然而,开发者在实际落地过程中面临三大核心挑战:

-

模型性能与效率的平衡难题 —— 大型模型虽然能力强大但难以在资源受限的端侧设备上流畅运行

-

多模态融合的技术门槛 —— 语音、视觉、文本等多模态能力的协同调用复杂度高

-

实时交互的体验优化 —— 语音合成、视频理解等场景对响应速度有极高要求。

这些痛点严重制约了 AI 技术在端侧场景的深度应用,开发者急需既保持高性能又具备端侧友好特性的开源模型解决方案。

面壁智能项目集群入驻 GitCode

现在,面壁智能三大核心项目:VoxCPM 语音模型、MiniCPM 4.1 文本模型和 MiniCPM-V 4.5 多模态模型已正式入驻 GitCode 平台,成为 G-Star 优秀毕业项目。这一系列模型突破正重新定义端侧智能的能力边界。

🔗 模型开源链接:

-

VoxCPM 语音模型:https://gitcode.com/OpenBMB/VoxCPM

-

MiniCPM 文本模型:https://gitcode.com/OpenBMB/MiniCPM

-

MiniCPM-V 4.5 多模态模型:https://ai.gitcode.com/OpenBMB/MiniCPM-V-4_5

1|语音新纪元:VoxCPM 实现零样本声音克隆

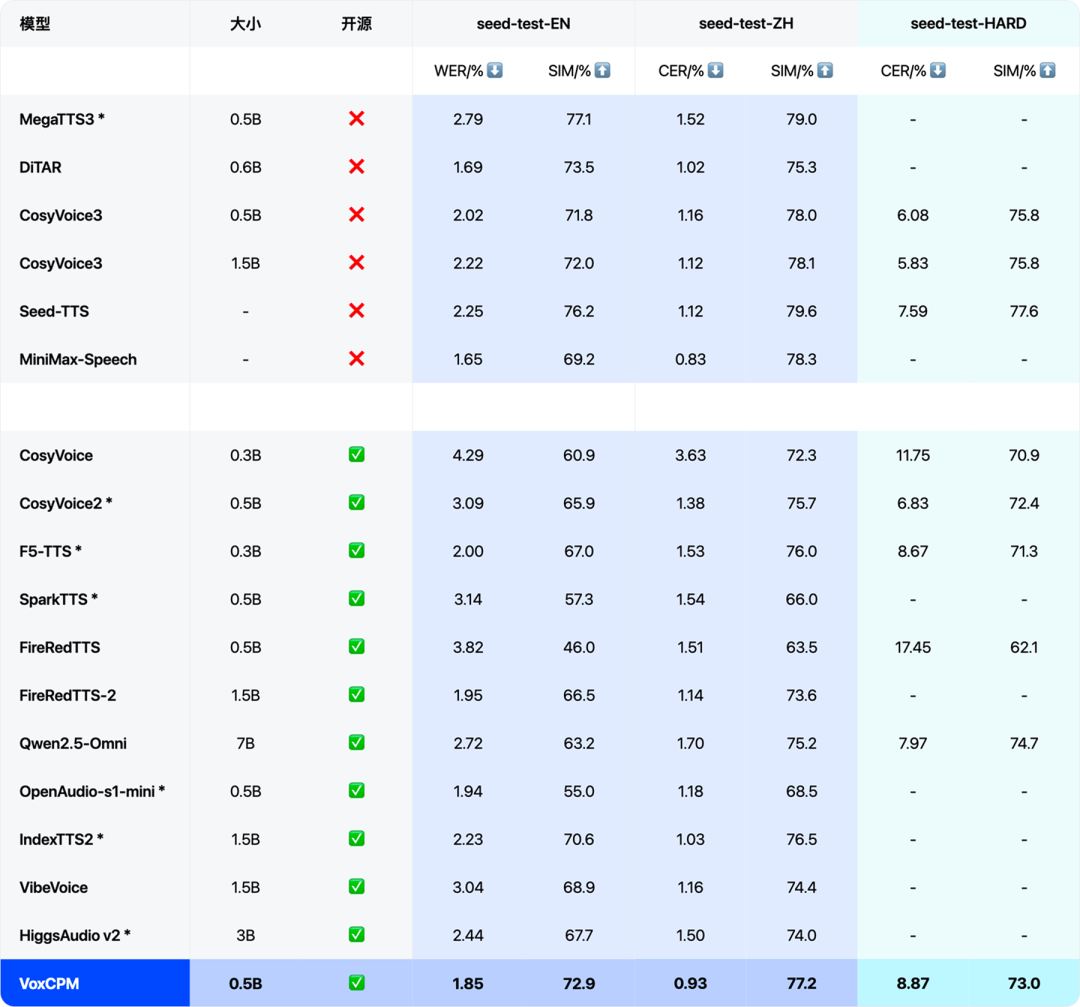

VoxCPM 作为 0.5B 参数的语音生成模型,在 Seed-TTS-EVAL 等权威评测中达到 SOTA 水平。该模型在音色相似度和词错误率指标上表现优异,尤其在零样本音色克隆任务中展现顶尖性能。

更令人惊喜的是其推理效率——在单张 RTX 4090 显卡上实现 RTF≈0.17 的实时因子,完全满足高质量实时交互需求。开发者可通过极少的样本数据生成个性化语音,支持中英双语复刻、公式符号音频合成等特色功能,为语音应用开发开辟了新可能。

2|文本推理革新:MiniCPM 4.1 引入稀疏架构

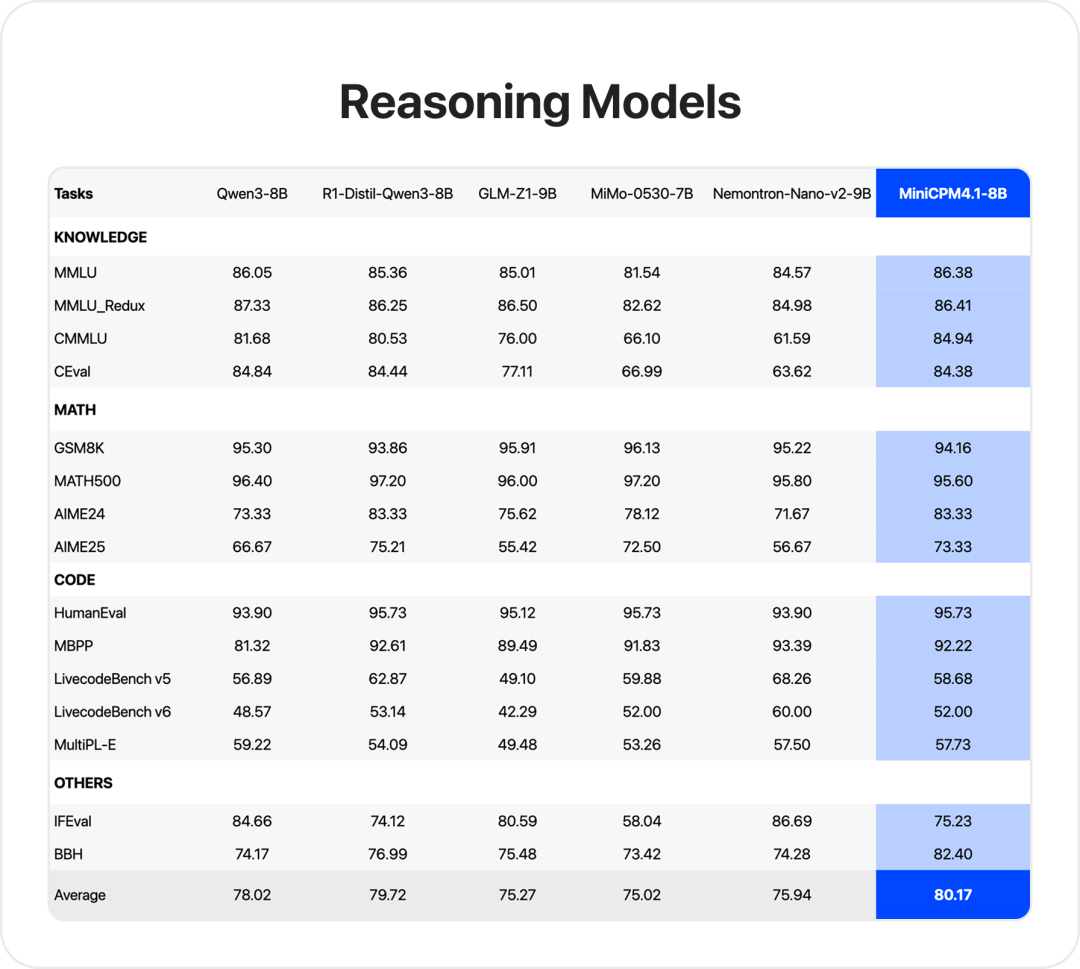

MiniCPM 4.1 的 8B 参数模型成为行业首个原生稀疏架构深思考模型。通过在 C-Eval、CMMLU、MMLU 等 15 个核心评测基准的综合表现中取得同尺寸模型最佳成绩,其在代码、数学推理任务上的速度比同尺寸模型快 3 倍以上。

该模型采用 InfLLM 2.0 稀疏注意力架构,将 128K 长文本的稀疏度降至 5%,注意力层仅需 1/10 计算量即可完成长文本处理。配合自研 CPM.cu 推理框架,实现了端侧设备的高效「深思考」能力。

3|MiniCPM-V 4.5 定义高刷流畅

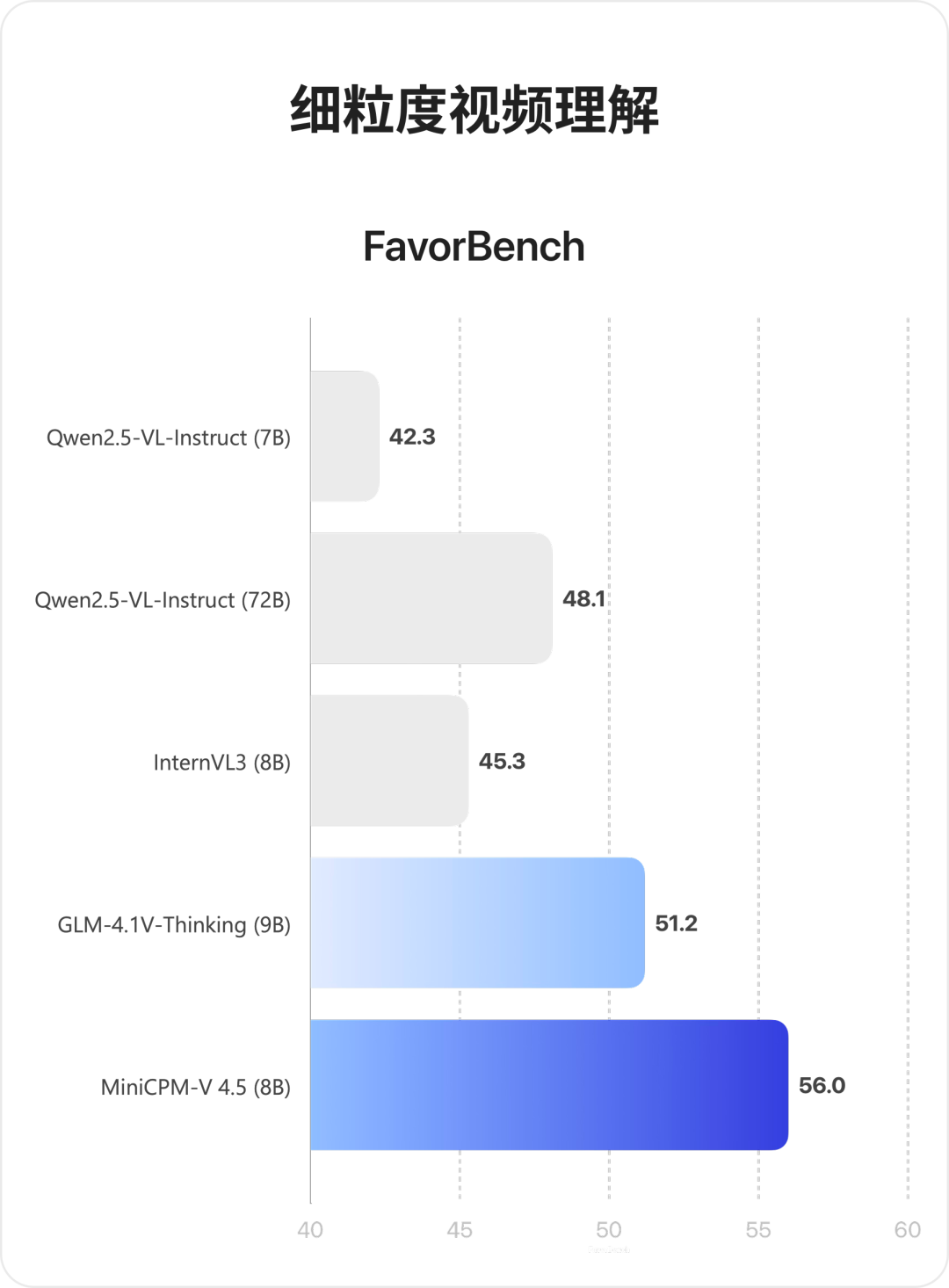

8B 参数的 MiniCPM-V 4.5 多模态模型成为行业首个具备“高刷”视频理解能力的多模态模型,高刷视频理解同级 SOTA 并超越 Qwen2.5-VL 72B,实现越级领先。

其核心创新在于 3D-Resampler 架构,将视觉压缩率提升至 96 倍,支持最大 10 fps 的高刷视频理解。这意味着模型从看「PPT」升级到理解「动态画面」。

共建端侧智能新生态

面壁智能此次开源的三款模型均注重端侧部署友好性,在保持高性能的同时显著降低显存占用和推理延迟。对于广大开发者而言,这些模型不仅提供了领先的 AI能力,更带来了切实可行的端侧部署方案,为移动端、边缘计算等场景的 AI 应用注入全新动力。

GitCode 将持续为这些项目提供技术支持与社区运营,通过各种形式促进项目与开发者社群的深度互动,进一步降低端侧 AI 的应用门槛。

👉 立即体验面壁智能开源模型:

-

VoxCPM 语音模型:https://gitcode.com/OpenBMB/VoxCPM

-

MiniCPM 文本模型:https://gitcode.com/OpenBMB/MiniCPM

-

MiniCPM-V 4.5 多模态模型:https://ai.gitcode.com/OpenBMB/MiniCPM-V-4_5

AtomGit 是由开放原子开源基金会联合 CSDN 等生态伙伴共同推出的新一代开源与人工智能协作平台。平台坚持“开放、中立、公益”的理念,把代码托管、模型共享、数据集托管、智能体开发体验和算力服务整合在一起,为开发者提供从开发、训练到部署的一站式体验。

更多推荐

已为社区贡献206条内容

已为社区贡献206条内容

所有评论(0)