spark之DataFrame的json数据实战

json

适用于现代 C++ 的 JSON。

项目地址:https://gitcode.com/gh_mirrors/js/json

·

一,DataFrame简介:

在Spark中,DataFrame是一种以RDD为基础的分布式数据据集,类似于传统数据库听二维表格,DataFrame带有Schema元信息,即DataFrame所表示的二维表数据集的每一列都带有名称和类型。

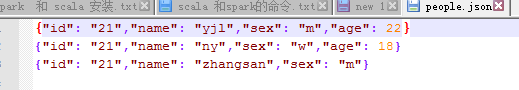

二,准备数据:

注意:json数据的格式,每一行都算是一个节点所以不能有空格,每行只能写一条数据。这里也是按行读入的。

三,代码及过程解释:

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.DataFrame;

import org.apache.spark.sql.SQLContext;

public class SparkSqlDemo {

//json数据的格式,每一行都算是一个节点所以不能有空格,每行只能写一条数据

private static String appName = "Test Spark RDD";

private static String master = "local";

public static void main(String[] args) {

SparkConf conf = new SparkConf();

conf.set("spark.testing.memory", "269522560000");

JavaSparkContext sc = new JavaSparkContext(master, appName, conf);

System.out.println( sc );

//通过sc建立sqlcontext

SQLContext sqlContext = new SQLContext(sc);

System.out.println(sqlContext );

//建立dataframe

DataFrame df = sqlContext.read().json("hdfs://192.168.61.128:9000/spark001/people.json");

//df.show();//展示所有信息

//df.printSchema();//显示数据的结构

//df.select(df.col("name")).show(); //条件查旬只显示数据的name

//条件查旬name age并且所有的age都加1,不会修改原来的数据

//df.select(df.col("name"), df.col("age").plus(1)).show();

//数据过滤只查旬比age比21大的数据

//df.filter(df.col("age").gt(21)).show();

//按age分组统计个年龄计数

df.groupBy("age").count().show();

}

}

适用于现代 C++ 的 JSON。

最近提交(Master分支:1 个月前 )

960b763e

4 个月前

8c391e04

6 个月前

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)