多个LLM?为什么不呢!

在JSON中提供模型卡名称,然后启动这些大模型!

在HuggingFace上,有成千上万的Llama和Mistral(以及其他基础模型)的衍生版本,针对各种用例和数据集进行了微调。

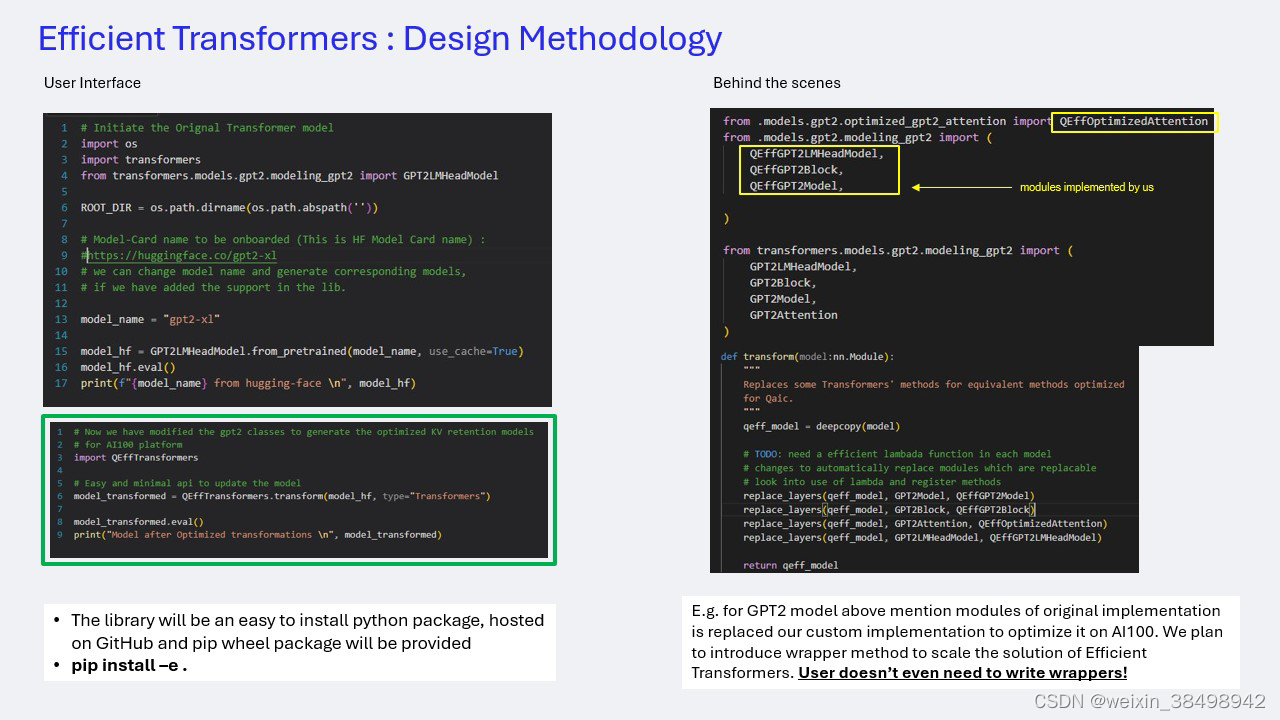

下面的插图展示了如何使用Efficient transformers API来一次性运行多个模型(在支持的模型架构中)。

用户提供模型的名称(如各自模型卡中所指定)作为库助手应用程序的输入(一个简单的应用程序,在循环中调用.infer() API),然后库生成所有这些模型的经过优化的推理容器.

如上所述,该库使开发者能够无缝地使用简单的API在AIC 100卡上运行他们的工作任务。

对于喜欢对工作任务进行更精细控制的开发者,该库还提供低级开发者API。

更进一步,该库还将集成到Qualcomm Cloud AI 100 Apps SDK的安装过程中。这使用户能够实现真正的一步模型到推理输出,并显著减少运行模型所需的步骤。

该库是产品栈与MLOps/LLOps开源产品之间的关键桥梁。Efficient transformers 将暴露出可以与Triton、LLM Serving stacks、K8s部署等集成的接口。它具有高度的可扩展性,可以进行特定模型的优化,而无需更改接口或使用API。

总结

随着深度学习领域以惊人的速度不断扩展,有必要持续进化硬件、软件和用户体验。要使任何软件工具链被广泛接受,使用的简易性至关重要,同时还需具备“编译一次,多平台部署”的能力。简化的从训练到推理的工作流程不仅能让开发者的工作变得更轻松,还能显著减少在不同领域部署LLM的时间和成本,并简化满足所需KPI的过程。

高通技术公司的Efficient transformers库提供了一种流线型的AI部署方法,无缝集成到现有框架中。通过处理模型特定优化的复杂性,它简化了从预训练模型到推理就绪解决方案的过渡,只需一次API调用。

有了这个库,开发者可以专注于项目的核心部分,确信推理处理得高效且有效。无论你是经验丰富的专业人士还是AI部署的新手,该库都能使你的旅程更顺畅、更易访问。

以下是文中提到的资源下载的连接:

- Amazon EC2 DL2q Instance

- Qualcomm Cloud AI home

- User Guide

- Qualcomm Cloud AI SDK download

- Qualcomm Cloud AI API reference

- OCP Microscaling Formats (MX) Specification

huggingface/transformers: 是一个基于 Python 的自然语言处理库,它使用了 PostgreSQL 数据库存储数据。适合用于自然语言处理任务的开发和实现,特别是对于需要使用 Python 和 PostgreSQL 数据库的场景。特点是自然语言处理库、Python、PostgreSQL 数据库。

最近提交(Master分支:2 个月前 )

33868a05

* [i18n-HI] Translated accelerate page to Hindi

* Update docs/source/hi/accelerate.md

Co-authored-by: K.B.Dharun Krishna <kbdharunkrishna@gmail.com>

* Update docs/source/hi/accelerate.md

Co-authored-by: K.B.Dharun Krishna <kbdharunkrishna@gmail.com>

* Update docs/source/hi/accelerate.md

Co-authored-by: K.B.Dharun Krishna <kbdharunkrishna@gmail.com>

* Update docs/source/hi/accelerate.md

Co-authored-by: K.B.Dharun Krishna <kbdharunkrishna@gmail.com>

---------

Co-authored-by: Kay <kay@Kays-MacBook-Pro.local>

Co-authored-by: K.B.Dharun Krishna <kbdharunkrishna@gmail.com> 12 天前

e2ac16b2

* rework converter

* Update modular_model_converter.py

* Update modular_model_converter.py

* Update modular_model_converter.py

* Update modular_model_converter.py

* cleaning

* cleaning

* finalize imports

* imports

* Update modular_model_converter.py

* Better renaming to avoid visiting same file multiple times

* start converting files

* style

* address most comments

* style

* remove unused stuff in get_needed_imports

* style

* move class dependency functions outside class

* Move main functions outside class

* style

* Update modular_model_converter.py

* rename func

* add augmented dependencies

* Update modular_model_converter.py

* Add types_to_file_type + tweak annotation handling

* Allow assignment dependency mapping + fix regex

* style + update modular examples

* fix modular_roberta example (wrong redefinition of __init__)

* slightly correct order in which dependencies will appear

* style

* review comments

* Performance + better handling of dependencies when they are imported

* style

* Add advanced new classes capabilities

* style

* add forgotten check

* Update modeling_llava_next_video.py

* Add prority list ordering in check_conversion as well

* Update check_modular_conversion.py

* Update configuration_gemma.py 13 天前

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)