6小时完成Llama 3.1-8B适配并开源!MindSpore Transformers大模型套件使能开发者创新

北京时间7月24号, Meta 正式发布 Llama 3.1开源大语言模型, 包含8B、70B 及 405B 参数版本。其中的Llama 3.1 405B模型,在多项基准测试中可以媲美GPT4、Claude3.5等目前最强的闭源大模型。此外,8B 与 70B 参数的 Llama 3.1 模型与其他参数量相似的闭源和开源模型相比,也同样具有竞争力。

01

6小时完成Llama 3.1适配

开发者基于MindSpore Transformers大模型套件,6小时完成Llama3.1-8b的微调及推理的迁移适配,并将代码开源至Gitee代码平台,面向所有开发者开放体验、调用,后续将同步上传至各大模型社区。

MindSpore Transformers Llama3.1代码仓地址:https://gitee.com/mindspore/mindformers/blob/dev/research/llama3_1

MindSpore代码仓地址:https://gitee.com/mindspore/mindspore

开发上,基于MindSpore Transformers大模型套件上开箱即用的Llama3进行微调和推理部署,即可得到Llama 3.1。

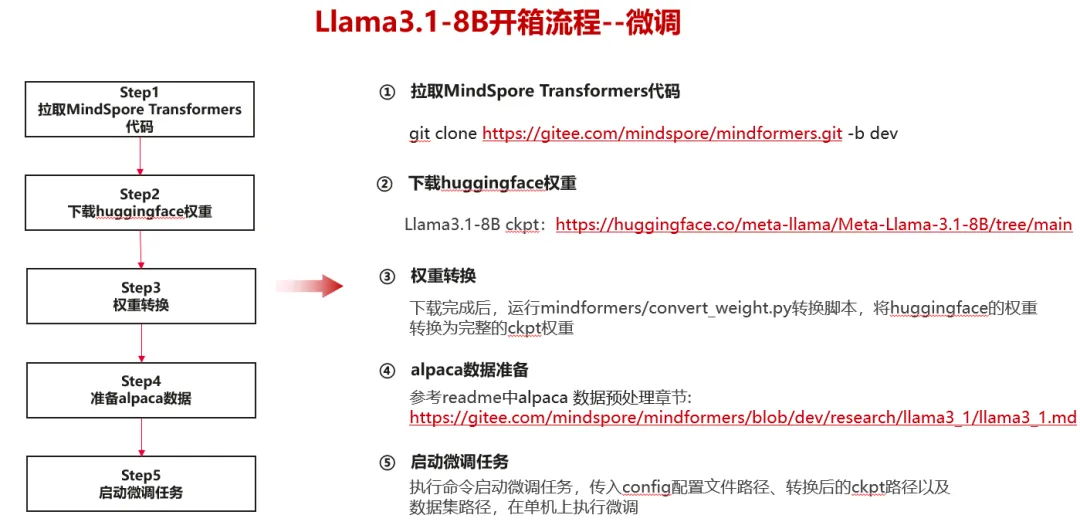

微调上,开发者利用大模型套件的权重转换工具,一行代码实现huggingface权重一键转化,同时通过使用MindFormers提供的Trainer等高阶易用性接口,仅需修改配置文件即可完成微调适配并成功跑通训练,loss曲线表明微调后训练任务稳定运行。

推理部署上,代码拉取、权重下载、权重转换步骤与微调一致,实现权重一键转换,推理结果显示,基于MindSpore Transformers适配的Llama 3.1模型精度与原生模型精度对齐。

MindSpore Transformers llama3.1开箱流程

微调:

模型跑通后,Loss曲线显示微调任务稳定运行。

推理:

02

关于MindSpore和MindSpore Transformers

昇思MindSpore是华为开源的首个业界全场景AI融合框架,原生支持AI大模型与科学智能。大模型开发套件MindSpore Transformers基于MindSpore内置的并行技术和组件化设计,构建了大模型训练、微调、评估、推理、部署的全流程开发套件,支持业内主流的Transformer类预训练模型和SOTA下游任务应用,可以帮助用户轻松的实现大模型训练和创新研发。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)