YOLOv10原创设计独立研发-二次创新-全网最新创新点改进系列:YOLOv10-NO.1-针对小目标、复杂场景等鲁棒性增强的全新V10网络架构。(全网无重复!)

YOLOv10原创自研-二次创新-全网最新创新点改进系列:YOLOv10-NO.1-针对小目标、复杂场景等鲁棒性增强的全新V10网络架构。

YOLOv10全网最新创新点改进系列项目 保底改进100+改进,努力冲刺200+

所有改进代码均经过实验测试跑通!截止发稿时YOLOv10已改进40+!自己排列组合2-4种后,考虑位置不同后可排列组合上千万种!改进不重样!!专注AI学术,关注B站up主:Ai学术叫叫兽er!

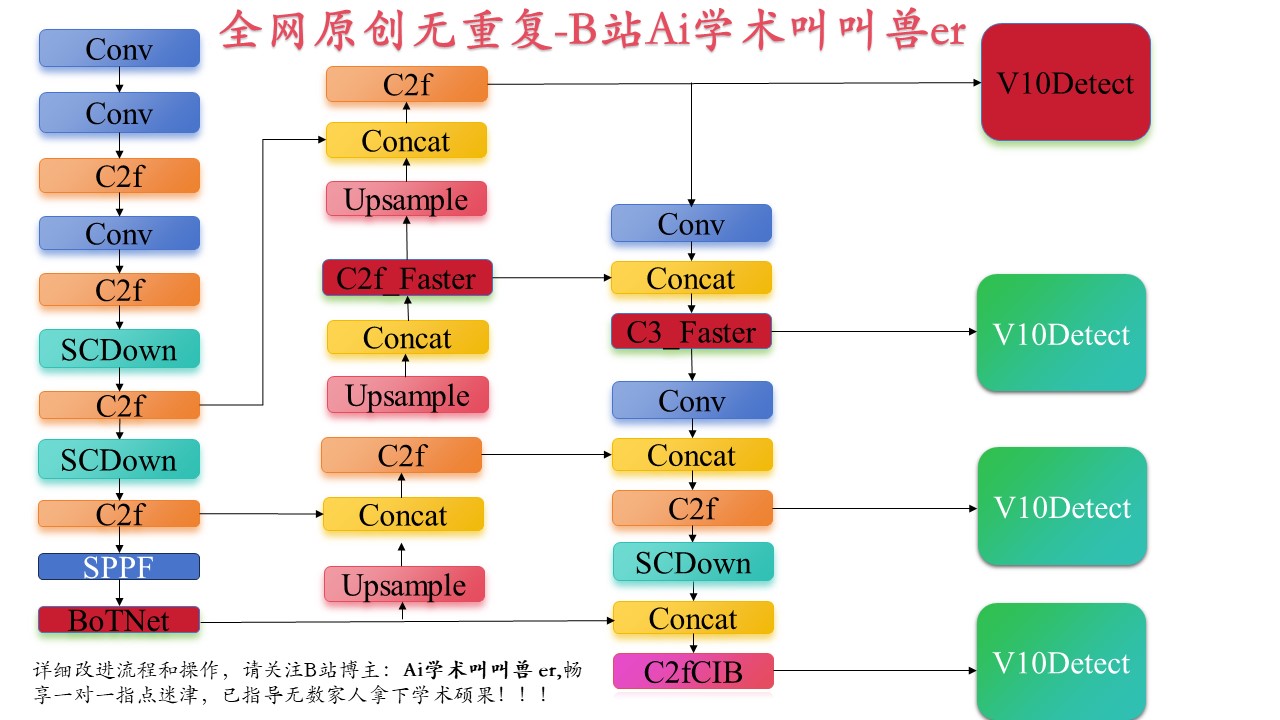

YOLOv10原创自研-二次创新-全网最新创新点改进系列:YOLOv10-NO.1-针对小目标、复杂场景等鲁棒性增强的全新V10网络架构图如下:

高清大图以及可编辑原图格式文件私信博主即可!

专栏为家人们提供跑通的改进源码以及原创自研的全新网络架构,资料中预留联系方式空闲时陪伴大家,一对一答疑。叫叫兽为科研成果而生!!!

专栏为家人们提供优化卷积、注意力机制、检测头改进、主干网络改进、颈部网络改进、损失函数针对性优化多项改进以及文章写作等定制化内容等!免费干货多多!关注B站Ai学术叫叫兽er!

购买相关资料后畅享一对一答疑!点击下方链接,告别导师放养、无人指导科研的疼苦!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

一、 BoTNet简介

BoTNet是一种简单但功能强大的主干网络,该架构将注意力模块纳入了包括图像分类,目标检测,实例分割等多种计算机视觉任务。通过仅将ResNet的最后三个的卷积层替换成MHSA层,并不进行其他改变,在墓边检测方面显著改善了极限,同时减少了参数两,从而使得延迟最小化。

Transformer中的MHSA和BoTNet中的MHSA的区别:

归一化,Transformer使用 Layer Normalization,而BoTNet使用 Batch Normalization。

非线性激活,Transformer仅仅使用一个非线性激活在FPN block模块中,BoTNet使用了3个非线性激活。

输出投影,Transformer中的MHSA包含一个输出投影,BoTNet则没有。

优化器,Transformer使用Adam优化器训练,BoTNet使用sgd+ momentum

AI学术叫叫兽er在这!家人们,给我遥遥领先!!!

AI学术叫叫兽er在这!家人们,给我遥遥领先!!!

AI学术叫叫兽er在这!家人们,给我遥遥领先!!!

二、 Faster Neural Networks简介

为了设计快速的神经网络,许多工作一直专注于减少浮点运算(Flop)的数量。然而,我们观察到,这种对FLOP的减少并不一定会导致类似水平的延迟减少。这主要源于低效的每秒浮点操作数(Flop)。为了实现更快的网络速度,我们重新审视了流行的运营商,并证明了这种低FLOPS主要是由于运营商频繁的内存访问,特别是深度卷积。因此,我们提出了一种新的部分卷积(PConv)方法,通过同时减少冗余的计算和内存访问来更有效地提取空间特征。在PConv的基础上,我们进一步提出了FasterNet,这是一种新的神经网络家族,在广泛的设备上获得了比其他网络更高的运行速度,而不会影响各种视觉任务的准确性。例如,在ImageNet1k上,我们的微小FasterNet-T0在GPU、CPU和ARM处理器上分别比MobileViT-XXS快2.8倍、3.3倍和2.4倍,而准确率则高出2.9%。我们的大型FasterNet-L达到了令人印象深刻的83.5%的TOP-1准确率,与新兴的Swin-B不相上下,同时在GPU上的推理吞吐量提高了36%,在CPU上节省了37%的计算时间。

三、增加检测头

近年来,越来越多的科研工作者将小目标检测作为研究方向,受YOLO相关算法的改进启发,本文通过增加了一个小目标探测头,以提高对较小目标的探测灵敏度,从而拉升模型的检测性能!

四、写在最后

学术因方向、个人实验和写作能力以及具体创新内容的不同而无法做到一通百通,所以本文作者即B站up主:Ai学术叫叫兽er在所有B站资料中留下联系方式以便在科研之余为家人们答疑解惑,本up主获得过国奖,发表多篇SCI,擅长目标检测领域,拥有多项竞赛经历,拥有软件著作权,核心期刊等经历。因为经历过所以更懂小白的痛苦!因为经历过所以更具有指向性的指导!

祝福所有科研工作者都能够在自己的领域上更上一层楼!!!

关注B站:Ai学术叫叫兽er

从此走上科研快速路

遥遥领先同行!!!!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽er 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

更多推荐

已为社区贡献53条内容

已为社区贡献53条内容

所有评论(0)