Flowise+OneAPI+Ollama搭建本地知识库问答

使用Flowise、OneAPI、Ollama搭建本地知识库问题,首选你要准备三台虚拟机,分别将这三种应用进行部署,默认使用的操作系统Ubuntu22.04。

一、搭建Ollama服务器

配置PVE虚拟机,Ollama要求有GPU卡24G或更高,内存建议32GB,当然越大越好。

安装英伟GPU的驱动,如何在ubuntu22.04上安装nvidia gpu卡,请自行搜索安装。

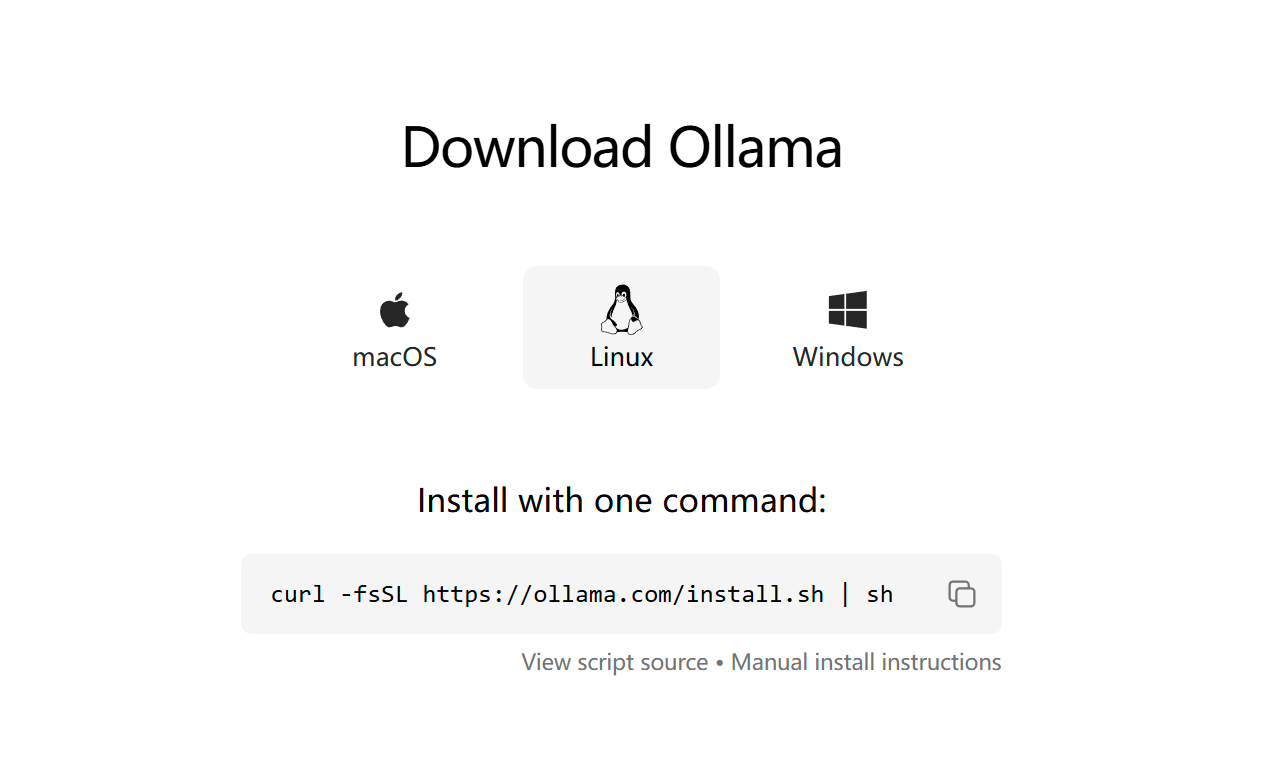

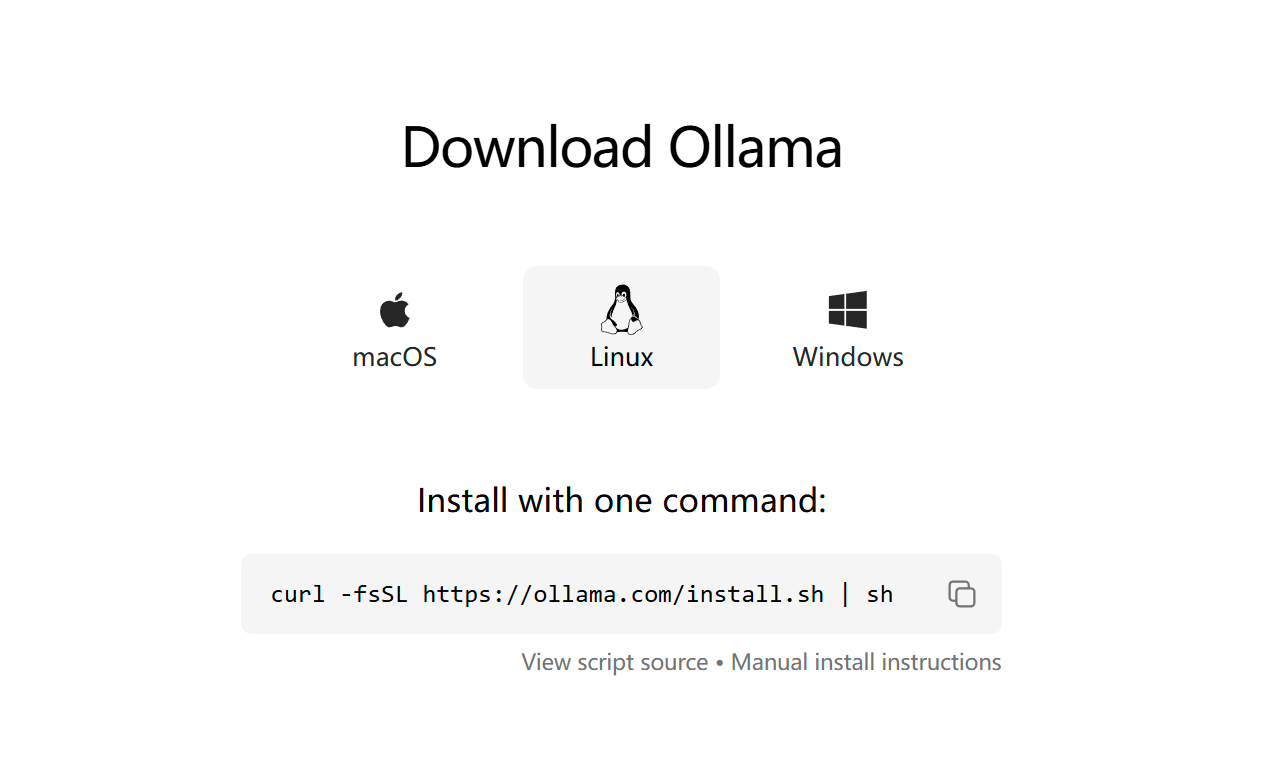

搭建Ollama服务器,请参考:https://ollama.com/download/linux

curl -fsSL https://ollama.com/install.sh | sh配置跨域访问:

vim /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

[Install]

WantedBy=default.target

修改ollama.service文件,如上代码。

#重新加载systemd守护进程并启用Ollama服务

sudo systemctl daemon-reload

sudo systemctl enable ollama

sudo systemctl start ollama二、搭建OneAPI服务器

要求4G内存,CPU设置1-2个都可以。

1、搭建OneAPI服务器请参考:使用OneAPI创建LLM访问API Key-CSDN博客

服务器搭建好后,启动OneAPI

cd /one-api

./one-api --port 3000 --log-dir ./logs打开浏览器访问oneapi

http://local-ip:3000

2、创建渠道

类型、名称:这两项可以随便写,你想叫啥名都行。

模型分组:假如你想分组就创建,不想分组管理就使用default就可以了。

模型名字:需要自己填写,如果你不清楚具体的名字,可以在ollama服务器上执行:ollama list

ollama list

NAME ID SIZE MODIFIED

qwen2:72b 14066dfa503f 41 GB 2 weeks ago

llama3.1:8b a340353013fd 4.7 GB 3 weeks ago

llama3.1:70b 74a390d90490 39 GB 3 weeks ago

gemma2:27b b8f858ce79c0 15 GB 6 weeks ago

gemma2:9b 6008d85d0646 5.5 GB 6 weeks ago

granite-code:34b 4ce00960ca84 19 GB 8 weeks ago

deepseek-v2:16b 35a3613ab60c 8.9 GB 8 weeks ago

qwen2:7b e0d4e1163c58 4.4 GB 8 weeks ago

llama3:70b 786f3184aec0 39 GB 8 weeks ago

llava-llama3:8b 44c161b1f465 5.5 GB 2 months ago

mixtral:8x7b d39eb76ed9c5 26 GB 2 months ago

wizardcoder:34b-python 94b069a3c250 19 GB 2 months ago

medllama2:7b a53737ec0c72 3.8 GB 2 months ago

command-r:35b b8cdfff0263c 20 GB 2 months ago

llava:13b 0d0eb4d7f485 8.0 GB 3 months ago

mistral:7b 61e88e884507 4.1 GB 3 months ago

llava:7b 8dd30f6b0cb1 4.7 GB 3 months ago

wizardlm2:7b c9b1aff820f2 4.1 GB 3 months ago

phi3:3.8b a2c89ceaed85 2.3 GB 3 months ago

llama3:8b a6990ed6be41 4.7 GB 3 months ago

照着list的NAME的名字写,名字写错了会报错的哦。

代理地址:即为你的ollama的服务器地址,一般为:

http://local-IP:11434

3、设置令牌

选择“添加新的令牌”

添加后,点复制即可以得到你的令牌key

保存你的key,这个key在接下来的Flowise工作流时需要用到。

4、如何判断你的配置有效

在渠道设置里面,点测试,可以查看oneapi连接ollama的准态,包括响应时间等信息。

三、搭建Flowise服务器

要求16G内存或更高(内存太小会报错),CPU设置2个以上。

搭建Flowise服务器请参考:Flowise在ubuntu22.04上的安装-CSDN博客

1、创建API Key

这个key是生成工作流后,外部访问的一个认证。

2、创建LLM的连接帐号

注意Flowise提供了各种API连接方式

在本例中我们选择LocalAI API

在这里CREDENTIAL NAME:名字可以随便写,只要方便你记住就行。

LocalAI Api Key:这里就是要填写你在OneAPI里面的复制的那个Key了。注意这里的Key是OneAPI提供的。

3、创建工作流

点Chatflows,创建工作流。

在Chat Models里面选择“ChatLocalAI”

ChatLocalAI的配置图

注意:BasePath:是你的OneAPI的地址,后面加上/v1,即:http://oneapi-ip:3000/v1

Model Name:一定要写ollama里面显示的NAME名字,区分大小写。

4、向量数据库

在Vector Stores里面找,这里选个简单的,In-Memory Vector Store。

5、问答及嵌入

如果你需要将这个问答嵌入到你的软件里,那么就点边里

可以将python代码嵌入到你的软件里面去。

当然你也可以将些网页共享,点Share Chatbot,此时可以直接生成一个网页进行访问。

访问该网页,就可以直接进行问答了。可以将些网页挂载到你的网站。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)