使用 ollama 部署本地模型,零基础入门到精通,非常详细收藏我这一篇就够了

一、什么是 ollama?

在本地启动并运行大型语言模型。运行Llama 2,Code Llama和其他模型。自定义并创建您自己的。

二、why ollama?

- 能直接运行大模型,与大模型进行对话。

- ollama 命令具有管理大模型的能力。

- 利用 cpu 运行大模型。

- 本地大模型安全可靠。

- 终端直接开始聊天。

- 社区提供了支持 web api 方式访问 WebUI。

如果你还没有尝试过在本地部署过大模型,那么 ollama 非常适合你。

三、准备工作

为了方便起见,先聊设备需求和辅助软件吧。部署大模型硬件还是要尽可能的高一些,因为文件比较大,虽然本地大模型对配置要求已经比较低了。

- docker 为了方便部署软件。

- 存储空间充足的机器,一般来说参数越大,需要配置越好。

- 良好的网络环境。

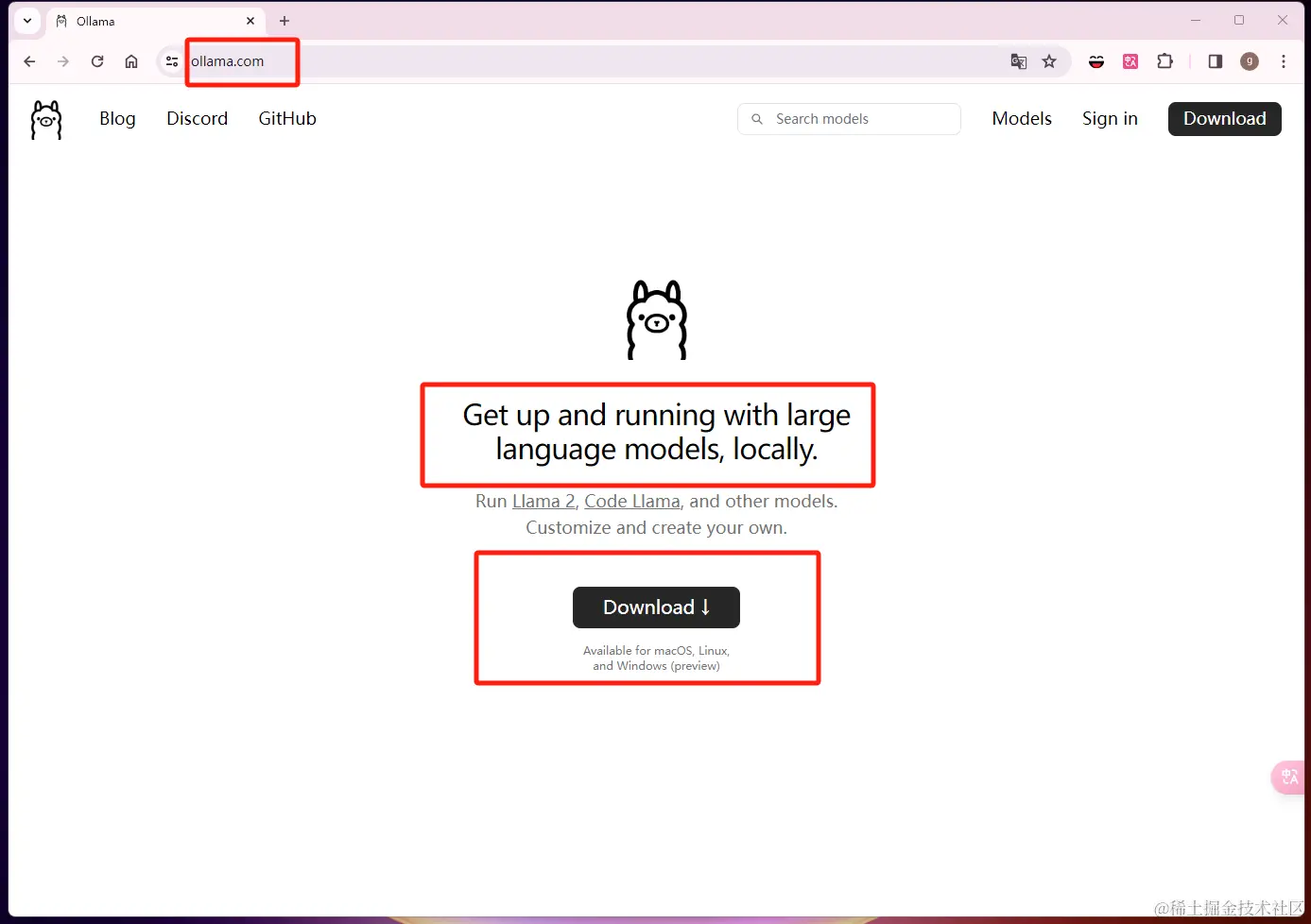

四、安装 ollama?

进入 ollama 下载页面,选择自己的系统版本的下载并安装即可。

4.1)检验是否安装成功

输入 Ollama 命令,正常的得出命令行输出,表示已经安装成功,下面有 ollama 的常用命令:

ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

五、ollama 模型库

我们可以在 ollama.com/library 中搜索已有我们想要的模型库。以下是一些流行的模型:

| 模型 | 参数 | 尺寸 | 执行下载 |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

这里大概列出了 Llama、Mistral 以及 Gemma 我们景见的模型以及参数以及尺寸大小。由图表可以看出 Gemma 2B 模型的尺寸还是比较小的,初学者入门。

六、运行模型

ollama run qwen # 运行千问大模型

因为qwen 模型对中文支持比较好,这里使用 qwen 模型进行聊天

直接使用 run 命令 + 模型名字就可以运行模型。如果之前没有下载过,那么会自动下载。下载完毕之后可以在终端中直接进行对话 qwen 模型了。

6.1)直接在终端中对话:用 ollama 千问模型写一个 React 组件

6.2)使用 api 方式运行

curl http://localhost:11434/api/chat -d '{

"model": "qwen",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

api 访问的方式:模型在不断推送字段。我们需要自己处理。

七、推荐 Open WebUI

LLMs用户友好的WebUI(以前的Ollama WebUI)

使用 docker 可以方便的部署

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

注意 3000 时长被其他的开发程序占用,使用需要注意自己的端口是否被占用。

7.1)注册

用户系统注册也是本地的,没有外部链接。

7.2)聊天界面

Open WebUI 聊天界面与

7.3)web ui 配置

八、小结

这是一篇入门 ollama 的文章,当然 ollama 的功能远不止如此,ollama 大部分代码基于 go 开发,熟悉 go 小伙伴很亲切。当然你可以自己构建自己的模型从 GGUF/pyTorch or Safetensors 等等。 ollama 的介绍就到这里了,希望能够帮助到有需要的小伙伴们。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

本文转自 https://blog.csdn.net/m0_65555479/article/details/141216341?spm=1001.2014.3001.5501,如有侵权,请联系删除。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)