CUDA安装&cuDNN、TensorRT版本匹配

安装适配版本的CUDA、cuDNN&TensorRT

模型部署推理时,涉及Trt与CUDA版本匹配的问题,本文记录一下如何查询匹配的CUDA,cuDNN和TensorRT版本,并配置安装。

先说版本结论:

40系卡推荐版本:CUDA-11.8,cuDNN-8.6.0,TensorRT-8.5.3.1

30系卡推荐版本:CUDA-11.1,cuDNN-8.2.1,TensorRT-8.2.4.2

具体可按下述步骤查看支持与匹配的版本:

一、 确定适合的版本

1. 查询显卡型号和计算能力

(1)Win + R,运行中输入dxdiag,弹出页面中查看显卡型号为:RTX 4060 Laptop

(2)打开如下网址:查看显卡对应的计算能力,本机RTX 4060 Laptop的计算能力为8.9

CUDA GPUs - Compute Capability | NVIDIA Developer

2. TensorRT查看支持计算能力的TensorRT版本和适配CUDA版本和cuDNN版本

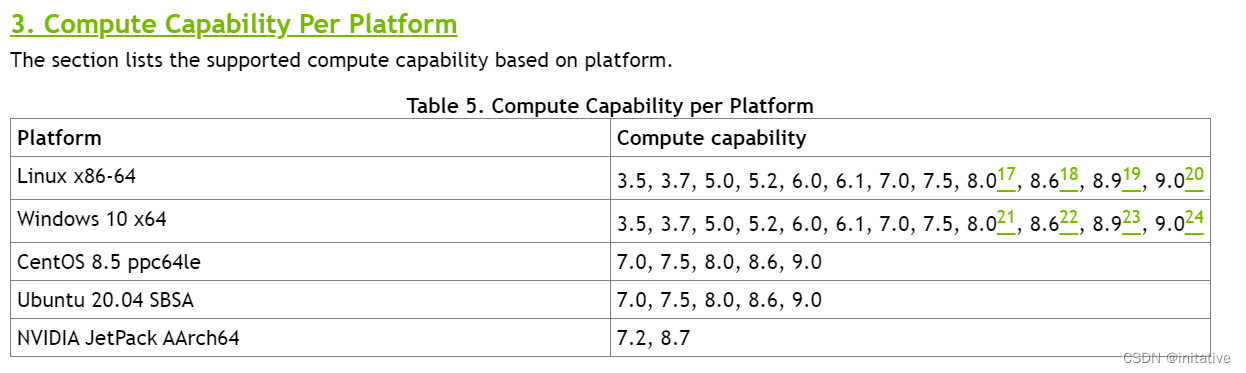

(1)打开TensorRT官网说明文档,查看各版本支持的计算能力。

https://docs.nvidia.com/deeplearning/tensorrt/archives/index.html#trt_8

(2)查看各版本支持的计算能力平台,支持8.9算力的最低TensorRT版本为8.5.1,版本选择一般选当前大版本下最新的小版本,此处选择TensorRT-8.5.3.1。根据脚注23说明,匹配的CUDA版本最低为CUDA-11.8

(3) 支持平台显示匹配的cuDNN版本为cuDNN 8.6.0

至此确定版本为:CUDA-11.8,cuDNN-8.6.0,TensorRT-8.5.3.1

30系卡推荐版本:CUDA-11.1,cuDNN-8.2.1,TensorRT-8.2.4.2

二、Windows下安装

1. CUDA安装

(1)以下网址查看CUDA历史版本,下载指定的版本

https://developer.nvidia.com/cuda-toolkit-archive

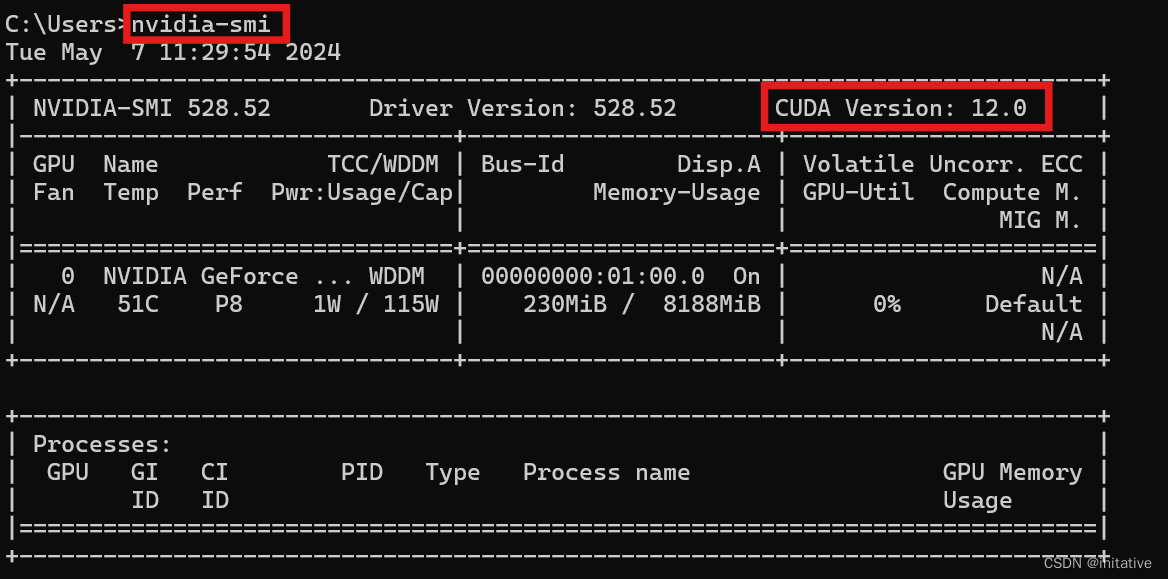

(2)下载完成后,双击按步骤进行即可。nvidia-smi查看当前显卡驱动最高支持的CUDA版本。如图,本机驱动版本为528.52,最高支持CUDA版本12.0

驱动支持选定的CUDA版本时,若不想切换显卡驱动,可选择自定义安装,取消勾选Driver components。

(3)安装多版本的CUDA可将系统变量和Path中要生效版本的环境变量移到上面

2. cuDNN安装

(1)以下网址查看cuDNN历史版本,选定对应的版本

https://developer.nvidia.com/cudnn-archive

(2)下载完成后,将压缩包中文件拷贝到CUDA安装的路径下即可。

3. TensorRT安装

(1)以下网址查看TensorRT历史版本,选择对应的版本下载

https://developer.nvidia.com/tensorrt/download

(2)将安装包解压到要放置的路径下,配置TensorRT的lib路径到环境变量Path中,生效版本以在上的版本为主:

(3)为了方便部署onnx模型,可将TrT中bin文件夹下可执行文件trtexec.exe文件拷贝到lib文件夹下。这样直接编辑bat脚本即可完成模型的部署

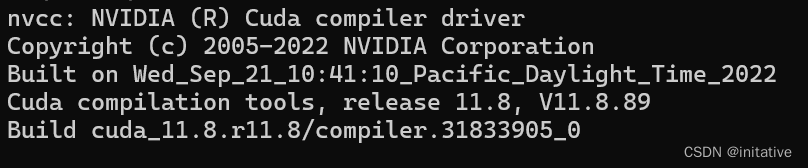

4. 验证CUDA安装成功

Windows终端输入指令,验证CUDA配置版本,完成安装

nvcc -V

AtomGit 是由开放原子开源基金会联合 CSDN 等生态伙伴共同推出的新一代开源与人工智能协作平台。平台坚持“开放、中立、公益”的理念,把代码托管、模型共享、数据集托管、智能体开发体验和算力服务整合在一起,为开发者提供从开发、训练到部署的一站式体验。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)