使用 Postman 批量发送请求的技巧

·

背景

最近写了几个接口:

- 获取 books 的接口

- 获取 likes 的接口

- 获取 collections 的接口

但是我还是不放心,因为这些接口到底稳不稳定呢?上线后有没有隐患呢?所以我想做一个批量发送接口模拟~

但是想要做到批量发送接口,必须要有一个条件批量发送 。

批量发送?

起因

当我们写一个接口时,并且部署时,一定要考虑一个问题:

- 你所做的产品访问量大吗?

- 你所写的接口和服务器能应对访问量大的场景吗?

比较你的产品有很多用户在同一时间去进行大批量的发送请求~

举个例子,公司只有一个入口,10 秒内能通过 1 w员工吗?

那肯定是不行的,那怎么办呢?那就要看你这个地铁入口怎么去做优化了

思考

但是你再怎么优化,你也不能马上就部署上线吧?肯定要在上线前,做一个规范的多接口批量发送,看看你写的接口,以及你的服务器,到底能不能承受住这样的压力

Postman 批量发送接口

创建集合和接口

首先是创建一个集合,并且依次添加

- 获取 books 的接口

- 获取 likes 的接口

- 获取 collections 的接口

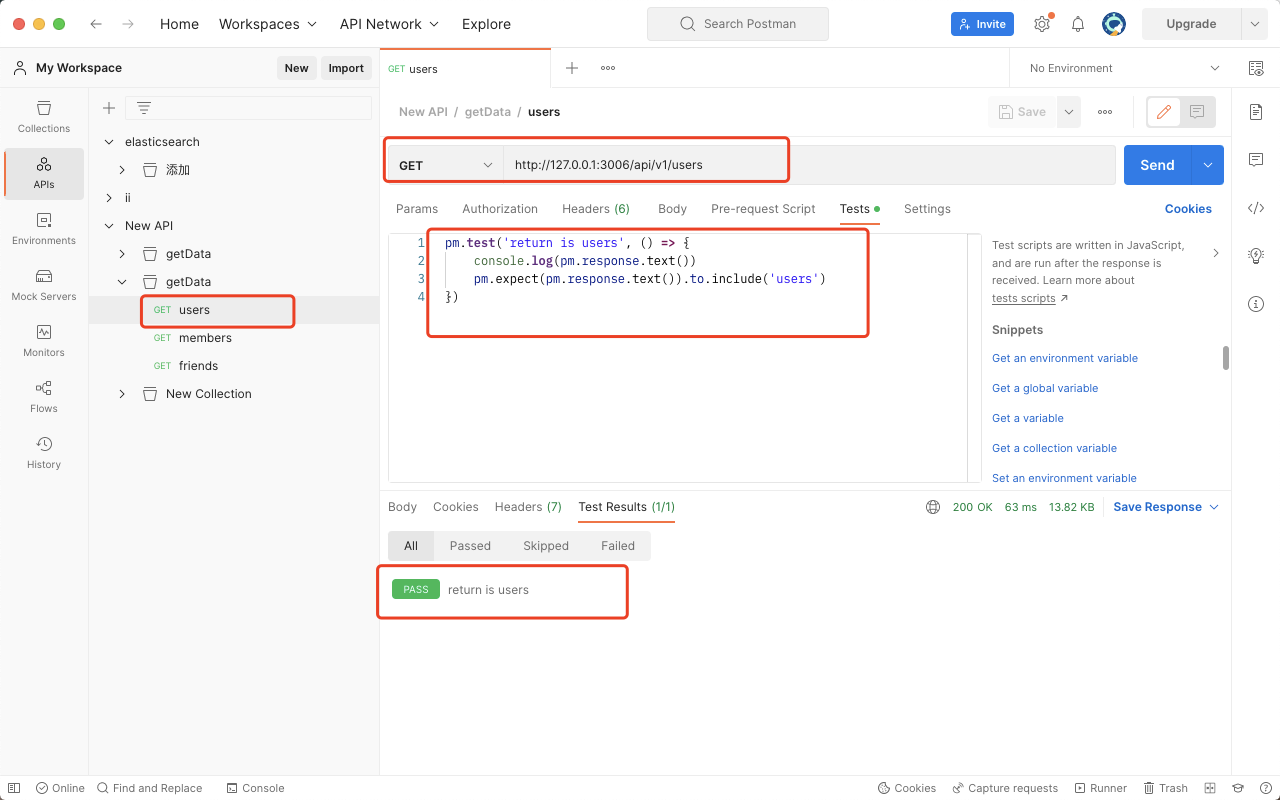

然后为了保险起见,在 Test 中添加断言校验

pm.test('返回数据是 books', () => {

console.log(pm.response.text())

pm.expect(pm.response.text()).to.include('books')

})

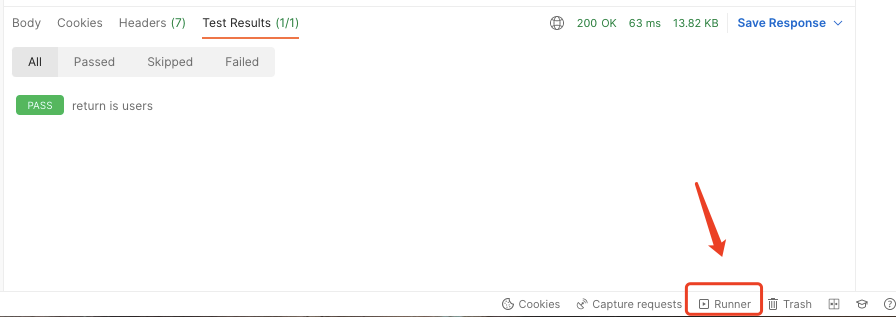

然后点击发送,我们会发现接口发送成功了,断言检验也通过了~~

批量发送接口

但是其实单个接口发送不是我们想要的,我们想要的是:

- 批量发送接口

- 频繁发送

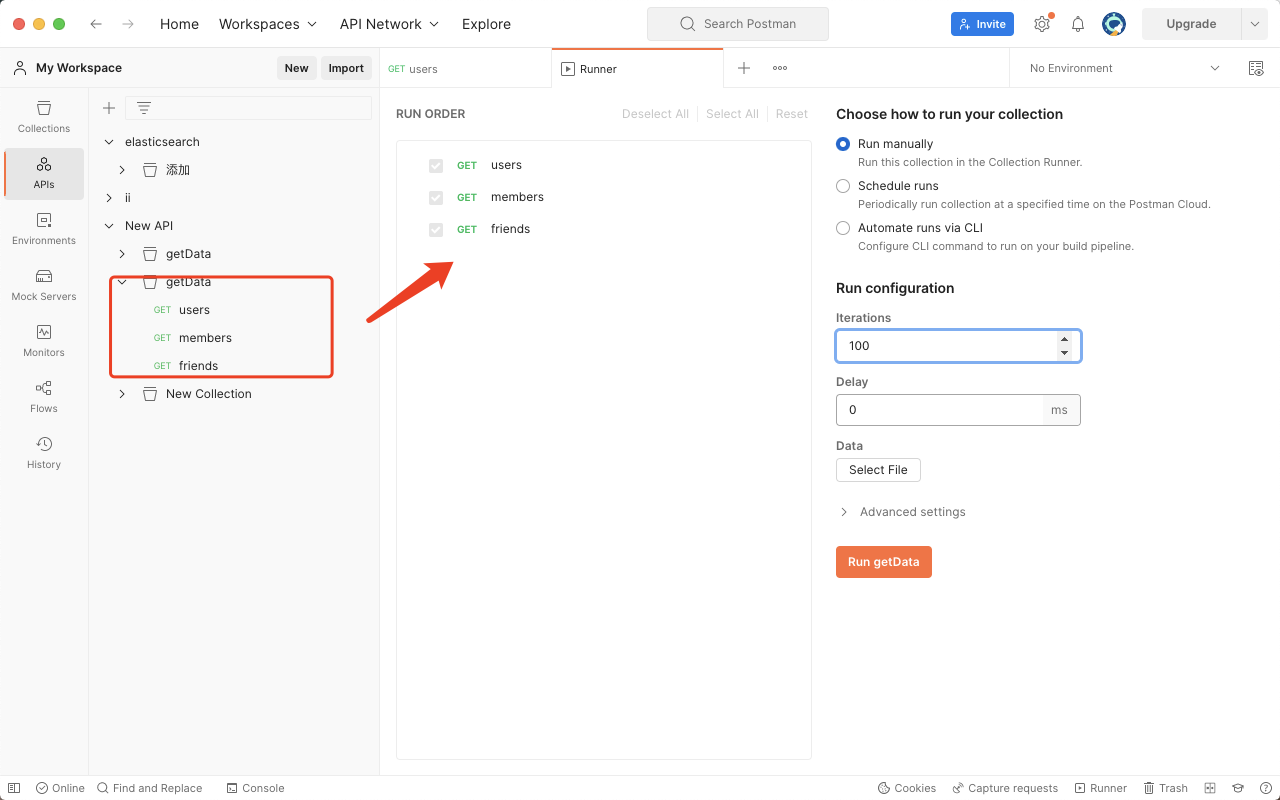

所以需要用到Postman的 Runner 功能

然后进行以下操作:

- 第一步:将整个集合拖拽进测试区

- 第二步:设置并发次数

- 第三步:设置每次并发的延迟

- 第四步:点击按钮进行批量发送接口

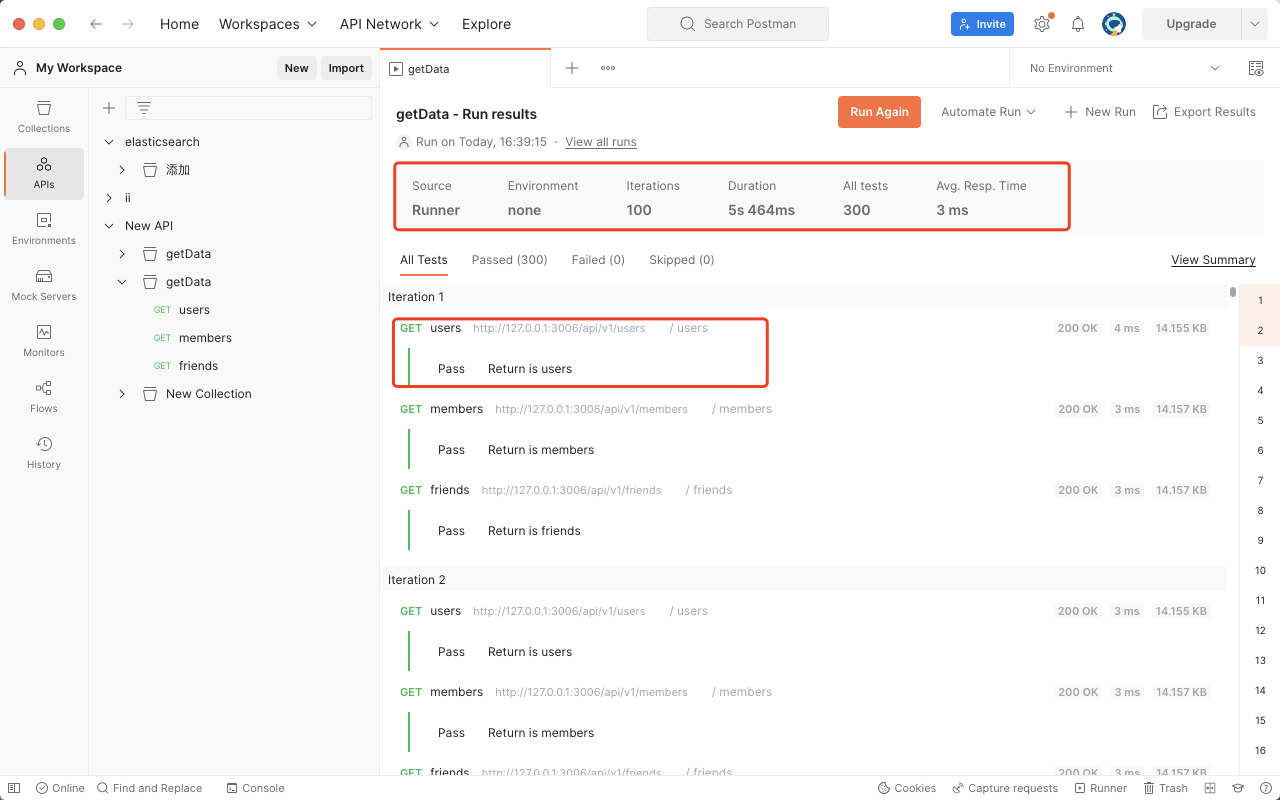

并且得到结果报告:

知识扩展:

学习更多 Postman 相关使用技巧。

推荐内容

阅读全文

AI总结

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

相关推荐

查看更多

Qwen3-Coder-480B-A35B-Instruct

Qwen3-Coder-480B-A35B-Instruct是当前最强大的开源代码模型之一,专为智能编程与工具调用设计。它拥有4800亿参数,支持256K长上下文,并可扩展至1M,特别擅长处理复杂代码库任务。模型在智能编码、浏览器操作等任务上表现卓越,性能媲美Claude Sonnet。支持多种平台工具调用,内置优化的函数调用格式,能高效完成代码生成与逻辑推理。推荐搭配温度0.7、top_p 0.8等参数使用,单次输出最高支持65536个token。无论是快速排序算法实现,还是数学工具链集成,都能流畅执行,为开发者提供接近人类水平的编程辅助体验。【此简介由AI生成】

Qwen3-235B-A22B-Instruct-2507

Qwen3-235B-A22B-Instruct-2507是一款强大的开源大语言模型,拥有2350亿参数,其中220亿参数处于激活状态。它在指令遵循、逻辑推理、文本理解、数学、科学、编程和工具使用等方面表现出色,尤其在长尾知识覆盖和多语言任务上显著提升。模型支持256K长上下文理解,生成内容更符合用户偏好,适用于主观和开放式任务。在多项基准测试中,它在知识、推理、编码、对齐和代理任务上超越同类模型。部署灵活,支持多种框架如Hugging Face transformers、vLLM和SGLang,适用于本地和云端应用。通过Qwen-Agent工具,能充分发挥其代理能力,简化复杂任务处理。最佳实践推荐使用Temperature=0.7、TopP=0.8等参数设置,以获得最优性能。

cherry-studio

🍒 Cherry Studio 是一款支持多个 LLM 提供商的桌面客户端

目录

所有评论(0)