dense层、激活函数、输出层设计

Tensorflow——tf.layers.densedense:全连接层相当于添加一个层,即初学的add_layer()函数tf.layers.dense(inputs,units,activation=None,use_bias=True,kernel_initializer=None,bias_initializer=tf.zeros_initializer(),kernel_regular

Tensorflow——tf.layers.dense

dense:全连接层

对于层方式的实现的时候!

layers.Dense(units,activation)函数一般只需要指定输出节点数Units和激活函数类型即可。输入节点数将根据第一次运算时输入的shape确定,同时输入、输出节点自动创建并初始化权值w和偏置向量b。其他的参数具体查看下方函数参数

使用Dense层的时候,Dense中的D记得要大写!!!

layers.Dense(256,activation='relu'),

Dense层的使用

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers,Sequential,losses,optimizers,datasets

model=keras.Sequential([

layers.Dense(256,activation='relu'),

layers.Dense(256,activation='relu'),

layers.Dense(256,activation='relu'),

layers.Dense(10),

])

model.build(input_shape=(4,284)) #必须build

model.summary()

tf.layers.dense(

inputs,

units,

activation=None,

use_bias=True,

kernel_initializer=None,

bias_initializer=tf.zeros_initializer(),

kernel_regularizer=None,

bias_regularizer=None,

activity_regularizer=None,

kernel_constraint=None,

bias_constraint=None,

trainable=True,

name=None,

reuse=None

)

inputs:输入该网络层的数据。

units: 输出的大小(维数),整数或long。

activation: 使用什么激活函数(神经网络的非线性层),默认为None,不使用激活函数。

use_bias: 使用bias为True(默认使用),不用bias改成False即可。

kernel_initializer:权重矩阵的初始化函数。 如果为None(默认值),则使用tf.get_variable使用的默认初始化程序初始化权重。

bias_initializer:bias的初始化函数。

kernel_regularizer:权重矩阵的正则函数。

bias_regularizer:bias的的正则函数。

activity_regularizer:输出的的正则函数。

kernel_constraint:由优化器更新后应用于内核的可选投影函数(例如,用于实现层权重的范数约束或值约束)。 该函数必须将未投影的变量作为输入,并且必须返回投影变量(必须具有相同的形状)。 在进行异步分布式培训时,使用约束是不安全的。

bias_constraint:由优化器更新后应用于偏差的可选投影函数。

trainable:Boolean,如果为True,还将变量添加到图集collectionGraphKeys.TRAINABLE_VARIABLES(参见tf.Variable)。

name:名字

reuse:Boolean,是否以同一名称重用前一层的权重。

作者:SpareNoEfforts

链接:https://www.jianshu.com/p/73a9742dc9e3

来源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

x = tf.random.normal([2,3])

model = layers.Sequential([

layers.Dense(2, activation=tf.nn.relu) ,

layers.Dense(2, activation=tf.nn.relu) ,

layers.Dense(2)

])

out = model(x)

model.kernel:返回Dense类的权值矩阵

model.bias:返回Dense类的偏置向量

model.trainable_variables:该参数会Sequential可训练的参数list (w1,b1,w2,b2,w3,b3…)

激活函数

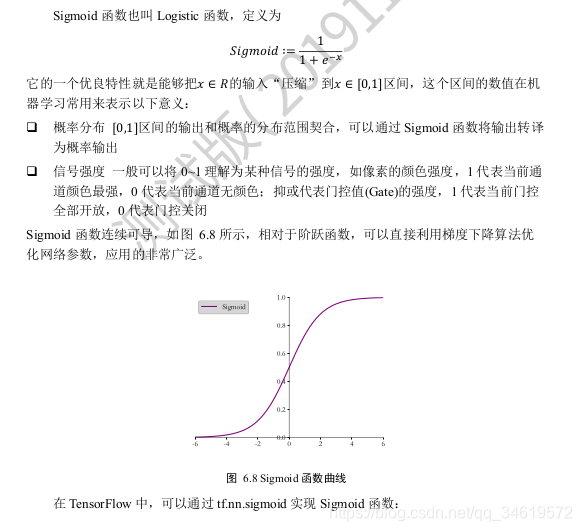

1.Sigmoid

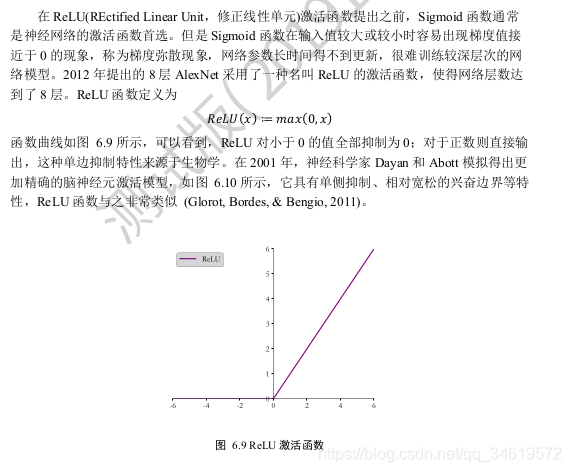

2.RELU

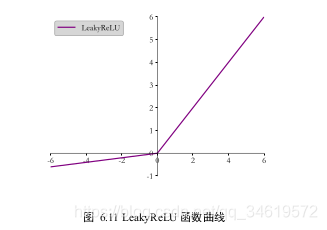

3. LeakyReLU

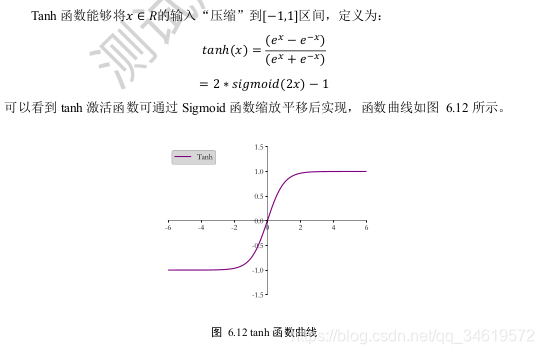

- Tanh

输出层设计

我们将根据输出值的区间范围来分类讨论。常见的几种输出类型包括:

❑ o ∈ R d 输出属于整个实数空间,或者某段普通的实数空间,比如函数值趋势的预测,年龄的预测问题等。输出层可以不加激活函数。误差的计算直接基于最后一层的输出o和真实值 y 进行计算,如采用均方差误差函数度量输出值o与真实值y之间的距

离:

❑ o ∈ [0,1] 输出值特别地落在[0, 1]的区间,如图片生成,图片像素值一般用[0, 1]表示;或者二分类问题的概率,如硬币正反面的概率预测问题Sigmoid!!

❑ o ∈ [0, 1], 输出值落在[0, 1]的区间,并且所有输出值之和为 1,常见的如多分类问题,如 MNIST 手写数字图片识别,图片属于 10 个类别的概率之和为 1。Softmax!!

❑ o ∈ [−1, 1] 输出值在[-1, 1]之间。tanh!!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)