I/O多路复用详解

I/O多路复用详解

文章目录

- I/O多路复用详解

- 什么是I/O多路复用

- 为什么要多路复用

- 常见I/O模型

- 同步阻塞IO

- 同步非阻塞IO

- IO多路复用

- 异步非阻塞IO

- select、poll、epoll详解

本文福利, 免费领取Linux C/C++ 开发学习资料包、技术视频/代码,1000道大厂面试题,内容包括(C++基础,网络编程,数据库,中间件,后端开发/音视频开发/Qt开发/游戏开发/Linuxn内核等进阶学习资料和最佳学习路线图)↓↓↓↓↓↓见下面↓↓文章底部点击免费领取↓↓

I/O多路复用详解

什么是I/O多路复用

- I/O模型是指网络I/O模型

- 是服务端如何管理连接,如何请求连接的措施,是用一个进程管理一个连接(PPC),还是一个线程管理一个连接(TPC),亦或者一个进程管理多个连接(Reactor)

- IO多路复用中多路就是多个TCP连接(或多个Channel),复用就是指复用一个或少量线程

- 是多个网路IO复用一个或少量线程来处理这些连接

为什么要多路复用

- 高性能

- 无论写一行代码还是做一个系统,都希望能够达到高性能的效果

- 高性能可以从两个方面考虑:

- 单机性能,将单服务器的性能发挥到极致

- 多机性能,设计服务器集群方案

- 单机高性能的关键之一就是服务器采取的网络编程模型

- 服务器如何管理连接,如何处理请求?

- I/O模型:阻塞、非阻塞、同步、异步

- 进程模型:单进程、多进程、多线程

常见I/O模型

- 同步阻塞IO(Blocking IO):即传统IO模型

- 同步非阻塞IO(Non-blocking IO):默认常见的socket都是阻塞的,非阻塞IO要求socket被设置成NONBLOCK

- IO多路复用(IO Multiplexing):即经典的Reactor设计模式,也被称为异步阻塞IO,Java中的selector和linux中的epoll都是这种模型

- 异步IO(Asychronous IO):即Proactor设计模式,也被称为异步非阻塞IO

同步和异步是指内核通知用户线程的方式。

- 用户进程/线程和内核是以传输层为分割线的

- 传输层以上是指用户进程

- 传输层以下(包括传输层)是指内核(处理所有通信细节,发送数据,等待确认,给无序到达的数据排序等,这四层是操作系统内核的一部分)

- 同步

- 用户线程发起IO请求后需要等待或者轮询内核IO操作,完成后才能继续执行

- 异步

- 用户线程发起IO请求后仍继续执行,当内核IO操作完成后回通知用户线程,或调用用户线程注册的回调函数。

阻塞和非阻塞是指用户线程调用内核IO操作的方式。

- 阻塞

- IO操作需要彻底完成后才能返回用户空间

- 非阻塞

- IO操作被调用后立即返回给用户一个状态值,无需等待IO操作彻底完成

同步阻塞IO

- 最简单的IO模型

- 用户线程在内核进行IO操作时被阻塞

- 用户线程通过调用系统调用read发起IO读操作,由用户空间转到内核空间。内核等到数据包到达后,然后将接受的数据拷贝到用户空间,完成read操作。整个IO请求过程,用户线程都是被阻塞的,对CPU利用率不够

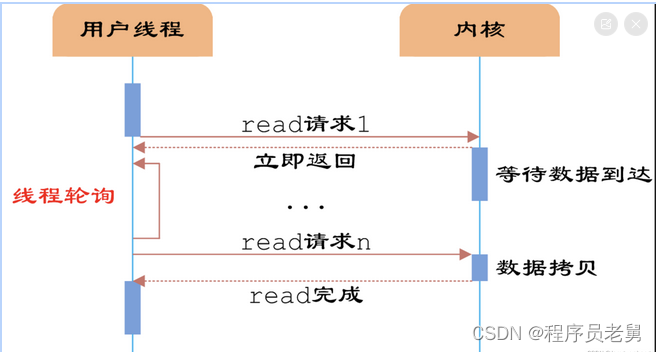

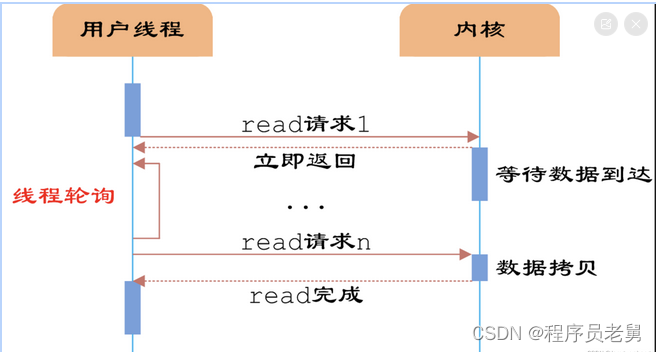

同步非阻塞IO

- 在同步基础上,将socket设置为NONBLOCK,用户线程可以在发起IO请求后立即返回

- 立即返回,但并未读到任何数据

- 用户线程需要不断的发起IO请求,直到数据到达后才能真正读到数据,然后去处理

- 同步的,为了等到数据,需要不断的轮询、重复请求,消耗了大量的CPU资源。实际用处不大

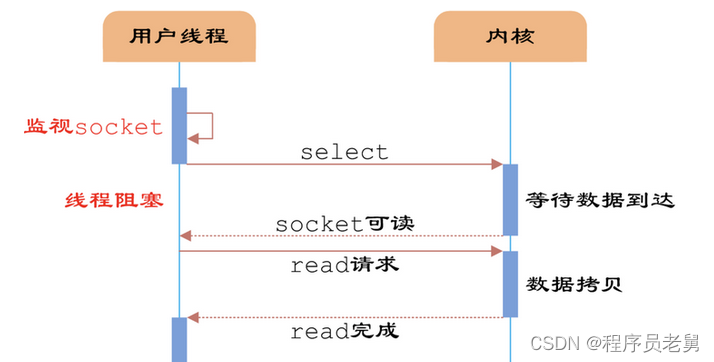

IO多路复用

- 一个或一组线程(线程池)处理多个TCP连接

- IO多路复用使用两个系统调用(select/poll/epoll和recvfrom),blocking IO只调用了recvfrom

- select/poll/epoll核心是可以同时处理多个connection,而不是更快,所以连接数不高的话,性能不一定比多线程+阻塞IO好。

- select是内核提供的多路分离函数,使用它可以避免同步非阻塞IO中轮询等待问题。

流程:

- 将需要进行IO操作的socket添加到select中,然后阻塞等待select系统调用返回

- 当数据到达时,socket被激活,select函数返回,用户线程正式发起read请求,读取数据并继续执行

同一个线程同时处理多个IO请求:

- 这种方式和同步阻塞IO并没有太大区别,还多了添加监视socket以及调用select函数的额外操作,效率更差

- 用户可以在一个线程内同时处理多个socket的IO请求,这就是它的最大优势。用户可以注册多个socket,然后不断调用select读取被激活的socket

- 同步阻塞模型中,必须通过多线程方式才能达到这个目的

所以IO多路复用设计目的其实不是为了快,而是为了解决线程/进程数量过多对服务器开销造成的压力。

select的缺点:

- 每个IO请求的过程还是阻塞的(在select函数上阻塞),平均时间甚至比同步阻塞IO模型还要长

- 如果用户线程只注册自己感兴趣的socket,然后去做自己的事情,等到数据到来时在进行处理,则可以提高CPU利用率

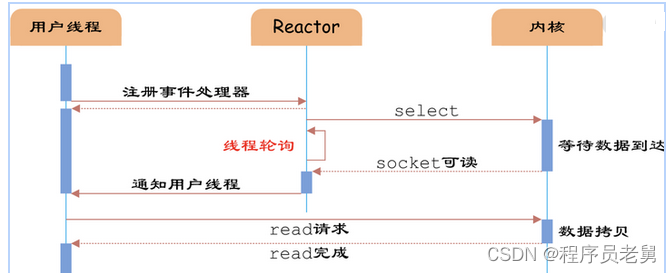

通过Reactor方式,用户线程轮询IO操作状态的工作统一交给handle_events事件循环处理。用户线程注册事件处理器之后可以继续执行做其他的工作(异步),而Reactor线程负责调用内核的select函数检查socket状态。当有socket被激活时,则通知相应的用户线程(或执行用户线程的回调函数),执行handel_envent进行数据的读取、处理工作。

由于select函数是阻塞的,因此多路IO复用模型就被称为异步阻塞IO模型,这里阻塞不是指socket。因为使用IO多路复用时,socket都设置NONBLOCK,不过不影响,因为用户发起IO请求时,数据已经到达了,用户线程一定不会被阻塞。

IO多路复用是最常用的IO模型,但其异步程度还不彻底,因为它使用了回阻塞线程的select系统调用。因此IO多路复用只能称为异步阻塞IO,而非真正的异步IO。

异步非阻塞IO

在IO多路复用模型中,事件循环文件句柄的状态事件通知给用户线程,由用户线程自行读取数据、处理数据。而异步IO中,当用户线程收到通知时候,数据已经被内核读取完毕,并放在了用户线程指定的缓冲区内,内核在IO完成后通知用户线程直接使用就行了。因此这种模型需要操作系统更强的支持,把read操作从用户线程转移到了内核。

相比于IO多路复用模型,异步IO并不十分常用,不少高性能并发服务程序使用IO多路复用+多线程任务处理的架构基本可以满足需求。不过最主要原因还是操作系统对异步IO的支持并非特别完善,更多的采用IO多路复用模拟异步IO方式(IO事件触发时不直接通知用户线程,而是将数据读写完毕后放到用户指定的缓冲区)。

select、poll、epoll详解

- select,poll,epoll都是IO多路复用的机制

- 异步阻塞IO,但select,poll,epoll本质上都是同步IO,因为它们都需要在续写事件就绪后自己负责进行读写,也就是说这个读写过程是阻塞的,而真正意义上的异步IO无需自己负责进行读写。

select

int select(int n, fd_set *readfds, fd_set *writefds, fd_set *exceptfds, struct timeval *timeout);

- 监视的文件描述符有三类,readfds,writefds,exceptfds

- 调用后函数会阻塞,直到有描述符就绪(有数据读、写、或者有except),或者超时(timeout指定时间,如果立即返回设置null),函数返回

- 当select函数返回后,可以通过遍历fdset,来找到就绪的描述符。

优点:

- 良好的跨平台性。

缺点:

- 单个进程能够监视的文件描述符的数量存在最大限制 在Linux上为1024可以通过修改宏定义甚至重新编译内核的方式提升这一限制,但这样会造成效率的降低

- 每次调用 select,都需要把 fd 集合从用户态拷贝到内核态,这个开销在 fd 很多时会很大

- 对 socket 扫描时是线性扫描,采用轮询的方法,效率较低(高并发)

poll

int poll(struct pollfd *fds, unsigned int nfds, int timeout);

struct pollfd{

int fd;

short events;

short revents;

};- 使用一个pollfd的指针实现

- pollfd结构包含了要监视的event和发生的event

- pollfd并没有最大数量的限制(但数量过大性能也会下降)

- poll返回后,需要遍历pollfd来或许就绪的描述符

缺点

- 每次调用 poll ,都需要把 fd 集合从用户态拷贝到内核态,这个开销在 fd 很多时会很大;

- 对 socket 扫描是线性扫描,采用轮询的方法,效率较低(高并发时)

epoll

每一个epoll对象都有一个独立的eventpoll结构体,用于存放通过epoll_ctl方法向epoll对象中添加进来的事件。这些事件都会挂载在红黑树中,如此,重复添加的事件就可以通过红黑树而高效的识别出来(红黑树的插入时间效率是lgn,其中n为红黑树元素个数)。

而所有添加到epoll中的事件都会与设备(网卡)驱动程序建立回调关系,也就是说,当相应的事件发生时会调用这个回调方法。这个回调方法在内核中叫ep_poll_callback,它会将发生的事件添加到rdlist双链表中,在epoll中,对于每一个事件,都会建立一个epitem结构体,如下所示:

struct epitem{

struct rb_node rbn;//红黑树节点

struct list_head rdllink;//双向链表节点

struct epoll_filefd ffd; //事件句柄信息

struct eventpoll *ep; //指向其所属的eventpoll对象

struct epoll_event event; //期待发生的事件类型

}当调用epoll_wait检查是否有事件发生时,只需要检查eventpoll对象中的rdlist双链表中是否有epitem元素即可。如果rdlist不为空,则把发生的事件复制到用户态,同时将事件数量返回给用户。

优点

- 没有最大并发连接的限制,能打开的FD的上限远大于1024(1G的内存上能监听约10万个端口);

- 效率提升,不是轮询的方式,不会随着FD数目的增加效率下降。

- 只有活跃可用的FD才会调用callback函数,只管理“活跃”的连接,而跟连接总数无关

- 内存拷贝,利用mmap()文件映射内存加速与内核空间的消息传递;即epoll使用mmap减少复制开销。

epoll缺点

- epoll只能工作在 linux 下

对于其他的IO模型比如IOCP或者kqueue之后再做补充

本文福利, 免费领取Linux C/C++ 开发学习资料包、技术视频/代码,1000道大厂面试题,内容包括(C++基础,网络编程,数据库,中间件,后端开发/音视频开发/Qt开发/游戏开发/Linuxn内核等进阶学习资料和最佳学习路线图)↓↓↓↓↓↓见下面↓↓文章底部点击免费领取↓↓

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)