Pytorch查看torch版本,查看torchvision版本,查看CUDA版本,查看cudnn版本,查看pytorch可用性,查看cuda可用性,查看cudnn可用性,查看显卡,指定运算GPU

·

文章目录

1 查看Pytorch版本

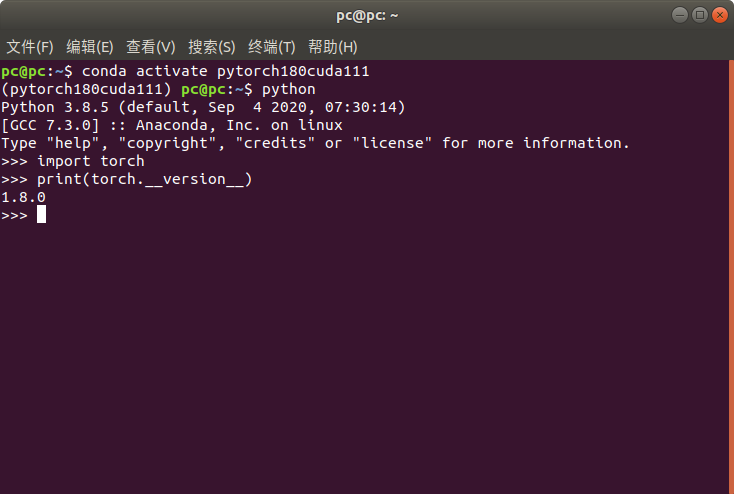

1.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch180cuda111

conda activate pytorch180cuda111

1.2 进入Python环境

输入python

python

1.3 查看pytorch版本

import torch #查看torch版本

print(torch.__version__) #注意是双下划线

2 查看torchvision版本

2.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch100

conda activate pytorch100

2.2 进入python环境

python

2.3 查看torchvision版本

import torchvision

print(torchvision.__version__)

这里没在原来电脑上演示,在另外一个环境,命令是一样的

3 查看cuda版本

3.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch180cuda111

conda activate pytorch180cuda111

3.2 进入Python环境

python

3.3 查看cuda版本

import torch

print(torch.version.cuda) #注意是双下划线

4 查看cudnn版本

4.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch180cuda111

conda activate pytorch180cuda111

4.2 进入Python环境

python

4.3 查看cudnn版本

import torch

print(torch.backends.cudnn.version()) #注意是双下划线

5 查看pytorch可用性

5.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch180cuda111

conda activate pytorch180cuda111

5.2 进入Python环境

python

5.3 查看pytorch可用性

import torch

a=torch.Tensor([1.])#如果pytorch可用则静默

6 查看cuda可用性

6.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch180cuda111

conda activate pytorch180cuda111

6.2 进入Python环境

python

6.3 查看cuda可用性

import torch

print(torch.cuda.is_available())#如果cuda可用,则返回True

7 查看cudnn可用性

7.1 打开终端,激活相应的环境

例如我的环境名称是:pytorch180cuda111

conda activate pytorch180cuda111

7.2 进入Python环境

python

7.3 查看cudnn可用性

import torch

# 若正常则静默

a = torch.tensor(1.)

# 若正常则静默

a.cuda()

# 若正常则返回 tensor(1., device='cuda:0')

from torch.backends import cudnn

# 若正常则静默

cudnn.is_available()

# 若正常则返回 True

cudnn.is_acceptable(a.cuda())

# 若正常则返回 True

8 查看显卡

8.1 查看显卡数量

torch.cuda.device_count() # 查看GPU数量

8.2 查看是否有可用GPU

torch.cuda.is_available() # 查看是否有可用GPU

8.3 查看GPU算力

torch.cuda.get_device_capability(device) # 查看指定GPU算力,参数device是数字,从0开始

#例如有两张显卡

torch.cuda.get_device_capability(0)#查看第0张显卡

torch.cuda.get_device_capability(1)#查看第1张显卡

8.4 查看GPU名称

torch.cuda.get_device_name(device) # 查看指定GPU名称,参数device是数字,从0开始

#例如有两张显卡

torch.cuda.get_device_name(0)#查看第0张显卡名称

torch.cuda.get_device_name(1)#查看第1张显卡名称

8.5 查看当前GPU

#查看当前使用的显卡,返回的是显卡的序号

torch.cuda.current_device()

8.6 查看GPU属性

## 查看显卡属性

import torch

[torch.cuda.get_device_properties(i) for i in range(torch.cuda.device_count())]

8.7 其他命令

torch.cuda.empty_cache() # 清空程序占用的GPU资源

torch.cuda.manual_seed(seed) # 设置随机种子

torch.cuda.manual_seed_all(seed) # 设置随机种子

9 指定显卡

9.1 在Pytorch程序里面指定显卡

import torch

# 设置torch的调用显卡(有效)

torch.cuda.set_device(1)

# 输出当前卡的信息

A=torch.arange(12,dtype=torch.float32)

B=A.cuda()

print(B.device)

print("A=\n",A)

9.2 在os里面指定显卡

通过os.environ[“CUDA_VISIBLE_DEVICES”]指定所要使用的显卡:

import os

os.environ['CUDA_VISIBLE_DEVICES'] = "2,1,3,4"

print("torch.cuda.device_count() {}".format(torch.cuda.device_count()))

这种设置方式,2号卡就变成了主卡。CUDA_VISIBLE_DEVICES 表示当前可以被python环境程序检测到的显卡。os.environ[“CUDA_VISIBLE_DEVICES”] = "2,1,3,4"进行指定使用设备,

这样会修改pytorch感受的设备编号,pytorch感知的编号还是从device:0开始。

如上会把2号显卡改为device:0,1号显卡改为device:1。

上述对GPU的设置一定要放在所有调用CUDA的代码之前,否者会不生效。torch.cuda.device_count()用于查看可用GPU的数量。

通过os.environ[“CUDA_VISIBLE_DEVICES”]设置系统变量后,可能会使torch.cuda.device_count()结果不准确。

10 终端里查看GPU信息

10.1 实时查看

watch -n 1 nvidia-smi

10.2 只查看此时的

nvidia-smi

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)