spark 源码分析

·

-

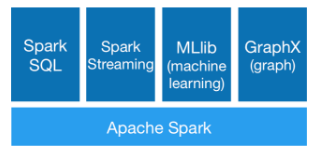

spark 整体架构

spark 四块最重要的:- sparkSql

- spark流处理

- 机器学习

- 图计算

-

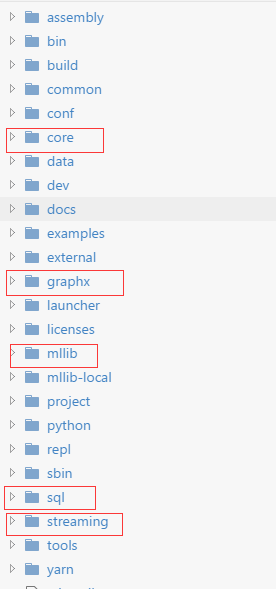

spark 2.0 源码结构

spark最核心的代码:https://github.com/apache/spark -

分析源码的方法

- 从bin 文件夹开始,我们同常会打开一个spark-shell, 提交任务spark-sbumit,

加入我们执行spark-submit, 那么打开spark-submit - spark-submit 实际上执行了: org.apache.spark.deploy.SparkSubmit 这个类文件

- org.apache.spark.deploy.SparkSubmit 的源码路径:core/src/main/scala/org/apache/spark/deploy/SparkSubmit.scala

- 然后打开:core/src/main/scala/org/apache/spark/deploy/SparkSubmit.scala

- 这样我们就进入了源码内部

- 从bin 文件夹开始,我们同常会打开一个spark-shell, 提交任务spark-sbumit,

-

举例分析—-spark-submit 到底干了什么?

- spark-submit 参数检测,添加jar 包

- 触发 –class 对应的类,执行我们自己代码的逻辑

- 代码逻辑中的每一个acction 操作都会触发 sparkContext 的runJob方法

- 随即触发dagScheduler.runJob, runJob 会 调用submitJob, 等待回调结果

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)